DeepSeek-R1: стимулирование способности к рассуждению у LLM с помощью обучения с подкреплением

На основе https://arxiv.org/abs/2501.12948

25 января 2025 года

Исследователи представили свои модели первого поколения, DeepSeek-R1-Zero и DeepSeek-R1. DeepSeek-R1-Zero, модель, обученная с использованием крупномасштабного обучения с подкреплением (RL) без предварительного этапа контролируемого дообучения (SFT), демонстрирует выдающиеся способности к рассуждению. Благодаря обучению с подкреплением, DeepSeek-R1-Zero естественным образом развивает множество мощных и интересных поведенческих моделей рассуждения. Однако она сталкивается с такими проблемами, как плохая читаемость и смешение языков. Для решения этих проблем и дальнейшего улучшения производительности рассуждений исследователи представили DeepSeek-R1, которая включает многоэтапное обучение и данные холодного старта перед RL. DeepSeek-R1 достигает производительности, сравнимой с OpenAI-o1-1217, на задачах рассуждения. В поддержку исследовательского сообщества, DeepSeek-R1-Zero, DeepSeek-R1 и шесть плотных моделей (1.5B, 7B, 8B, 14B, 32B, 70B), дистиллированных из DeepSeek-R1 на основе Qwen и Llama, были открыты для публичного доступа.

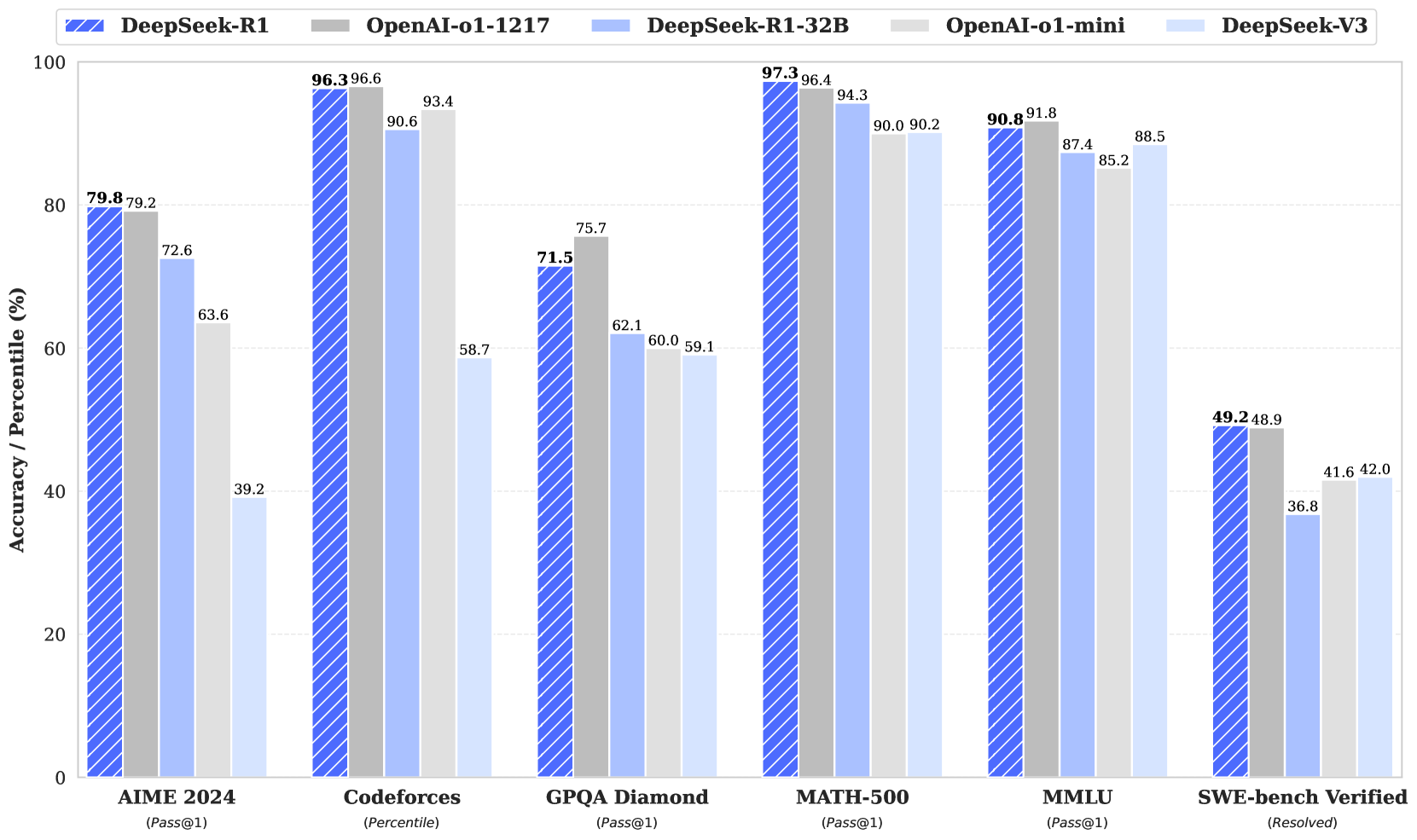

Рис.1. Benchmark performance of DeepSeek-R1

Введение

В последние годы большие языковые модели (LLMs) быстро развиваются и совершенствуются (OpenAI, 2024a; Anthropic, 2024; Google, 2024), постепенно сокращая разрыв на пути к созданию искусственного общего интеллекта (AGI).

Недавно пост-обучение стало важным компонентом полного цикла обучения. Оно показало свою эффективность в повышении точности выполнения задач, связанных с рассуждением, согласовании с социальными ценностями и адаптации к предпочтениям пользователей, при этом требуя относительно небольших вычислительных ресурсов по сравнению с предварительным обучением. В контексте способностей к рассуждению, модели серии o1 от OpenAI (OpenAI, 2024b) первыми представили масштабирование на этапе вывода за счёт увеличения длины процесса цепочки рассуждений. Этот подход достиг значительных улучшений в различных задачах, связанных с рассуждением, таких как математика, программирование и научные рассуждения. Однако проблема эффективного масштабирования на этапе тестирования остаётся открытым вопросом для исследовательского сообщества. Несколько предыдущих работ исследовали различные подходы, включая модели вознаграждения на основе процессов (Uesato et al., 2022; Lightman et al., 2023; Wang et al., 2023), обучение с подкреплением (Kumar et al., 2024) и алгоритмы поиска, такие как Monte Carlo Tree Search и Beam Search (Feng et al., 2024; Xin et al., 2024; Trinh et al., 2024). Однако ни один из этих методов не достиг общей производительности рассуждений, сравнимой с моделями серии o1 от OpenAI.

В данной работе исследователи делают первый шаг к улучшению способностей языковых моделей к рассуждению с использованием чистого обучения с подкреплением (RL). Их цель заключается в исследовании потенциала LLMs развивать способности к рассуждению без каких-либо контролируемых данных, сосредоточившись на их самоэволюции через процесс чистого RL. В частности, они используют DeepSeek-V3-Base в качестве базовой модели и применяют GRPO (Shao et al., 2024) в качестве фреймворка RL для улучшения производительности модели в рассуждениях. В ходе обучения DeepSeek-R1-Zero естественным образом развивает множество мощных и интересных поведенческих моделей рассуждения. После тысяч шагов RL DeepSeek-R1-Zero демонстрирует превосходную производительность на тестах по рассуждению. Например, показатель pass@1 на AIME 2024 увеличивается с 15.6% до 71.0%, а при использовании голосования по большинству он улучшается до 86.7%, сравниваясь с производительностью OpenAI-o1-0912.

Однако DeepSeek-R1-Zero сталкивается с проблемами, такими как плохая читаемость и смешение языков. Для решения этих проблем и дальнейшего улучшения производительности рассуждений исследователи представили DeepSeek-R1, которая включает небольшое количество данных холодного старта и многоэтапный процесс обучения. В частности, они начинают со сбора тысяч данных холодного старта для дообучения базовой модели DeepSeek-V3. После этого они проводят RL, ориентированное на рассуждения, аналогично DeepSeek-R1-Zero. Приближаясь к сходимости в процессе RL, они создают новые данные SFT через отбор отказов на контрольной точке RL, комбинируя с контролируемыми данными из DeepSeek-V3 в таких областях, как написание текстов, фактические вопросы и ответы, и самопознание, а затем переобучают базовую модель DeepSeek-V3. После дообучения с новыми данными контрольная точка проходит дополнительный процесс RL, учитывая подсказки из всех сценариев. После этих шагов они получили контрольную точку, известную как DeepSeek-R1, которая достигает производительности на уровне OpenAI-o1-1217.

Исследователи также изучили дистилляцию из DeepSeek-R1 в более мелкие плотные модели. Используя Qwen2.5-32B (Qwen, 2024b) в качестве базовой модели, прямая дистилляция из DeepSeek-R1 превосходит применение RL на ней. Это демонстрирует, что модели рассуждений, обнаруженные более крупными базовыми моделями, имеют решающее значение для улучшения способностей к рассуждению. Они открыли исходный код дистиллированных серий Qwen и Llama (Dubey et al., 2024). Примечательно, что их дистиллированная модель 14B значительно превосходит лучшую на сегодняшний день открытую модель QwQ-32B-Preview (Qwen, 2024a), а дистиллированные модели 32B и 70B устанавливают новый рекорд на тестах по рассуждению среди плотных моделей.

Вклад исследователей

Пост-обучение: Крупномасштабное обучение с подкреплением на базовой модели

Исследователи применили обучение с подкреплением (RL) непосредственно к базовой модели, не полагаясь на контролируемое дообучение (SFT) в качестве предварительного этапа. Такой подход позволяет модели исследовать цепочку рассуждений (CoT) для решения сложных задач, что привело к созданию DeepSeek-R1-Zero. DeepSeek-R1-Zero демонстрирует такие способности, как самопроверка, рефлексия и генерация длинных цепочек рассуждений, что является значительным достижением для исследовательского сообщества. Важно отметить, что это первое открытое исследование, подтверждающее, что способности к рассуждению у больших языковых моделей могут быть стимулированы исключительно через RL, без необходимости в SFT. Этот прорыв открывает путь для будущих достижений в данной области.

Исследователи представили свой конвейер для разработки DeepSeek-R1. Конвейер включает два этапа RL, направленных на улучшение паттернов рассуждения и согласование с предпочтениями человека, а также два этапа SFT, которые служат основой для рассуждающих и нерассуждающих способностей модели. Они считают, что этот конвейер принесет пользу индустрии, способствуя созданию более совершенных моделей.

Дистилляция: Меньшие модели также могут быть мощными

Исследователи продемонстрировали, что паттерны рассуждения больших моделей могут быть дистиллированы в меньшие модели, что приводит к лучшей производительности по сравнению с паттернами рассуждения, обнаруженными через RL на малых моделях. Открытый исходный код DeepSeek-R1, а также его API, будут полезны исследовательскому сообществу для дистилляции более совершенных малых моделей в будущем.

Используя данные о рассуждениях, сгенерированные DeepSeek-R1, исследователи доработали несколько плотных моделей, широко используемых в исследовательском сообществе. Результаты оценки показывают, что дистиллированные меньшие плотные модели демонстрируют исключительно высокую производительность на тестах. DeepSeek-R1-Distill-Qwen-7B достигает 55.5% на AIME 2024, превосходя QwQ-32B-Preview. Кроме того, DeepSeek-R1-Distill-Qwen-32B набирает 72.6% на AIME 2024, 94.3% на MATH-500 и 57.2% на LiveCodeBench. Эти результаты значительно превосходят предыдущие модели с открытым исходным кодом и сопоставимы с o1-mini. Исследователи открыли исходный код дистиллированных контрольных точек 1.5B, 7B, 8B, 14B, 32B и 70B на основе серий Qwen2.5 и Llama3 для сообщества.

Полученный результат

Задачи, связанные с рассуждением:

- DeepSeek-R1 достигает показателя 79.8% Pass@1 на AIME 2024, немного превосходя OpenAI-o1-1217. На тесте MATH-500 модель набирает впечатляющие 97.3%, демонстрируя производительность на уровне OpenAI-o1-1217 и значительно опережая другие модели.

- В задачах, связанных с программированием, DeepSeek-R1 демонстрирует экспертный уровень в соревнованиях по программированию, достигая рейтинга Эло 2029 на Codeforces и превосходя 96.3% участников-людей. В инженерных задачах DeepSeek-R1 показывает себя немного лучше, чем DeepSeek-V3, что может помочь разработчикам в реальных задачах.

Знания: На тестах, таких как MMLU, MMLU-Pro и GPQA Diamond, DeepSeek-R1 достигает выдающихся результатов, значительно превосходя DeepSeek-V3 с показателями 90.8% на MMLU, 84.0% на MMLU-Pro и 71.5% на GPQA Diamond. Хотя её производительность немного уступает OpenAI-o1-1217 на этих тестах, DeepSeek-R1 превосходит другие модели с закрытым исходным кодом, демонстрируя своё конкурентное преимущество в образовательных задачах. На фактическом тесте SimpleQA, DeepSeek-R1 превосходит DeepSeek-V3, демонстрируя свою способность обрабатывать запросы, основанные на фактах. Аналогичная тенденция наблюдается, когда OpenAI-o1 превосходит 4o на этом тесте.

Прочие задачи: DeepSeek-R1 также преуспевает в широком спектре задач, включая творческое письмо, ответы на общие вопросы, редактирование, суммирование и другие. Модель достигает впечатляющего показателя побед с контролем длины 87.6% на AlpacaEval 2.0 и показателя побед 92.3% на ArenaHard, демонстрируя свою сильную способность интеллектуально обрабатывать запросы, не связанные с экзаменами. Кроме того, DeepSeek-R1 демонстрирует выдающуюся производительность в задачах, требующих понимания длинного контекста, значительно превосходя DeepSeek-V3 на тестах с длинным контекстом.

Подход DeepSeek

Предыдущие работы в значительной степени полагались на большие объемы контролируемых данных для улучшения производительности моделей. В данном исследовании ученые демонстрируют, что способности к рассуждению могут быть значительно улучшены с помощью крупномасштабного обучения с подкреплением (RL), даже без использования контролируемого дообучения (SFT) в качестве начального этапа. Более того, производительность может быть дополнительно улучшена с включением небольшого количества начальных данных. В следующих разделах представлены: (1) DeepSeek-R1-Zero, которая применяет RL непосредственно к базовой модели без каких-либо данных SFT, и (2) DeepSeek-R1, которая применяет RL, начиная с контрольной точки, доработанной с использованием тысяч длинных примеров цепочки рассуждений (CoT). (3) Дистилляция способностей к рассуждению из DeepSeek-R1 в малые плотные модели.

DeepSeek-R1-Zero: Обучение с подкреплением на базовой модели

Обучение с подкреплением продемонстрировало значительную эффективность в задачах рассуждения, что подтверждается предыдущими работами ученых (Wang et al., 2023; Shao et al., 2024). Однако эти работы в значительной степени зависели от контролируемых данных, сбор которых требует много времени. В этом разделе исследователи исследуют потенциал больших языковых моделей (LLMs) развивать способности к рассуждению без каких-либо контролируемых данных, сосредоточившись на их самоэволюции через процесс чистого обучения с подкреплением. Они начинают с краткого обзора своего алгоритма RL, за которым следует представление некоторых захватывающих результатов, и надеются, что это предоставит сообществу ценные идеи.

Групповая относительная оптимизация политики

Для экономии затрат на обучение с подкреплением исследователи используют метод групповой относительной оптимизации политики (GRPO) (Shao et al., 2024), который отказывается от использования модели критика, обычно имеющей тот же размер, что и модель политики, и оценивает базовый уровень на основе групповых оценок. Конкретно, для каждого вопроса \(q\), GRPO выбирает группу ответов \(\{o_1, o_2, \ldots, o_G\}\) из старой политики \(\pi_{\theta_{\text{old}}}\) и затем оптимизирует модель политики \(\pi_{\theta}\), максимизируя следующий целевой функционал:

\[ \mathcal{J}_{\text{GRPO}}(\theta) = \mathbb{E} \left[ q \sim P(Q), \{o_i\}_{i=1}^G \sim \pi_{\theta_{\text{old}}}(O|q) \right] \frac{1}{G} \sum_{i=1}^G \left( \min \left( \frac{\pi_{\theta}(o_i|q)}{\pi_{\theta_{\text{old}}}(o_i|q)} A_i, \text{clip} \left( \frac{\pi_{\theta}(o_i|q)}{\pi_{\theta_{\text{old}}}(o_i|q)}, 1 - \epsilon, 1 + \epsilon \right) A_i \right) - \beta \mathcal{D}_{\text{KL}}(\pi_{\theta} \| \pi_{\text{ref}}) \right),\]

где расстояние Кульбака-Лейблера \(\mathcal{D}_{\text{KL}}\) определяется как:

\[ \mathbb{D}_{\mathrm{KL}}(\pi_\theta \parallel \pi_{\mathrm{ref}}) = \frac{\pi_{\mathrm{ref}}(o_i | q)}{\pi_\theta(o_i | q)} - \log \left( \frac{\pi_{\mathrm{ref}}(o_i | q)}{\pi_\theta(o_i | q)} \right) - 1\]

где \(\epsilon\) и \(\beta\) являются гиперпараметрами, а \(A_i\) — это преимущество, вычисляемое с использованием группы вознаграждений \(\{r_1, r_2, \ldots, r_G\}\), соответствующих ответам в каждой группе:

\[ A_i = \frac{r_i - \text{mean}(\{r_1, r_2, \ldots, r_G\})}{\text{std}(\{r_1, r_2, \ldots, r_G\})}.\]

Промпт для DeepSeek-R1-Zero

A conversation between User and Assistant. The user asks a question, and the Assistant solves it.

The assistant first thinks about the reasoning process in the mind and then provides the user

with the answer. The reasoning process and answer are enclosed within <think> </think> and

<answer> </answer> tags, respectively, i.e., <think> reasoning process here </think>

<answer> answer here </answer>. User: #prompt#. Assistant: Во время обучения #prompt# заменяется на конкретный вопрос, связанный с рассуждением.

Моделирование наград (reward modeling)

Награда выступает источником обучающего сигнала, который определяет направление оптимизации в процессе обучения с подкреплением. Для обучения модели DeepSeek-R1-Zero используется система наград на основе правил, включающая два основных типа:

-

Награды за точность: Модель точности оценивает корректность ответа. Например, в случае математических задач с детерминированным решением модель должна представить окончательный ответ в заранее заданном формате (например, внутри специального поля), что позволяет автоматически проверять его правильность. Аналогично, для задач LeetCode можно использовать компилятор, который предоставляет обратную связь на основе заранее заданных тестовых случаев.

-

Награды за формат: Помимо оценки точности, применяется модель наград за формат, которая требует от модели вывода мыслительного процесса между тегами «

».

В ходе разработки DeepSeek-R1-Zero не используются нейросетевые модели наград, поскольку было замечено, что они могут быть уязвимы к явлению "reward hacking" (поиску способов максимизировать награду нечестным образом) при масштабном обучении с подкреплением. Кроме того, переобучение модели наград требует дополнительных вычислительных ресурсов и усложняет общую систему обучения.

Процесс обучения

Для обучения модели DeepSeek-R1-Zero исследователи разработали простой шаблон, который направляет базовую модель на выполнение заданных инструкций. Как показано в Таблице 1, этот шаблон предписывает модели сначала представить процесс рассуждений, а затем — окончательный ответ. Ограничения носят исключительно структурный характер: никакие конкретные стратегии решения задач или особенности содержания (например, обязательное использование рефлексивного подхода к решению) не навязываются. Это позволяет сохранить естественную динамику развития модели в процессе обучения с подкреплением и более точно наблюдать за её эволюцией.

| Model | AIME 2024 | MATH-500 | GPQA | LiveCode | CodeForces Diamond Bench (pass@1) | rating |

|---|---|---|---|---|---|---|

| OpenAI-o1-mini | 63.6 | 80.0 | 90.0 | 60.0 | 53.8 | 1820 |

| OpenAI-o1-0912 | 74.4 | 83.3 | 94.8 | 77.3 | 63.4 | 1843 |

| DeepSeek-R1-Zero | 71.0 | 86.7 | 95.9 | 73.3 | 50.0 | 1444 |

Таблица 1. Сравнение моделей DeepSeek-R1-Zero и OpenAI o1 на тестах, связанных с рассуждениями.

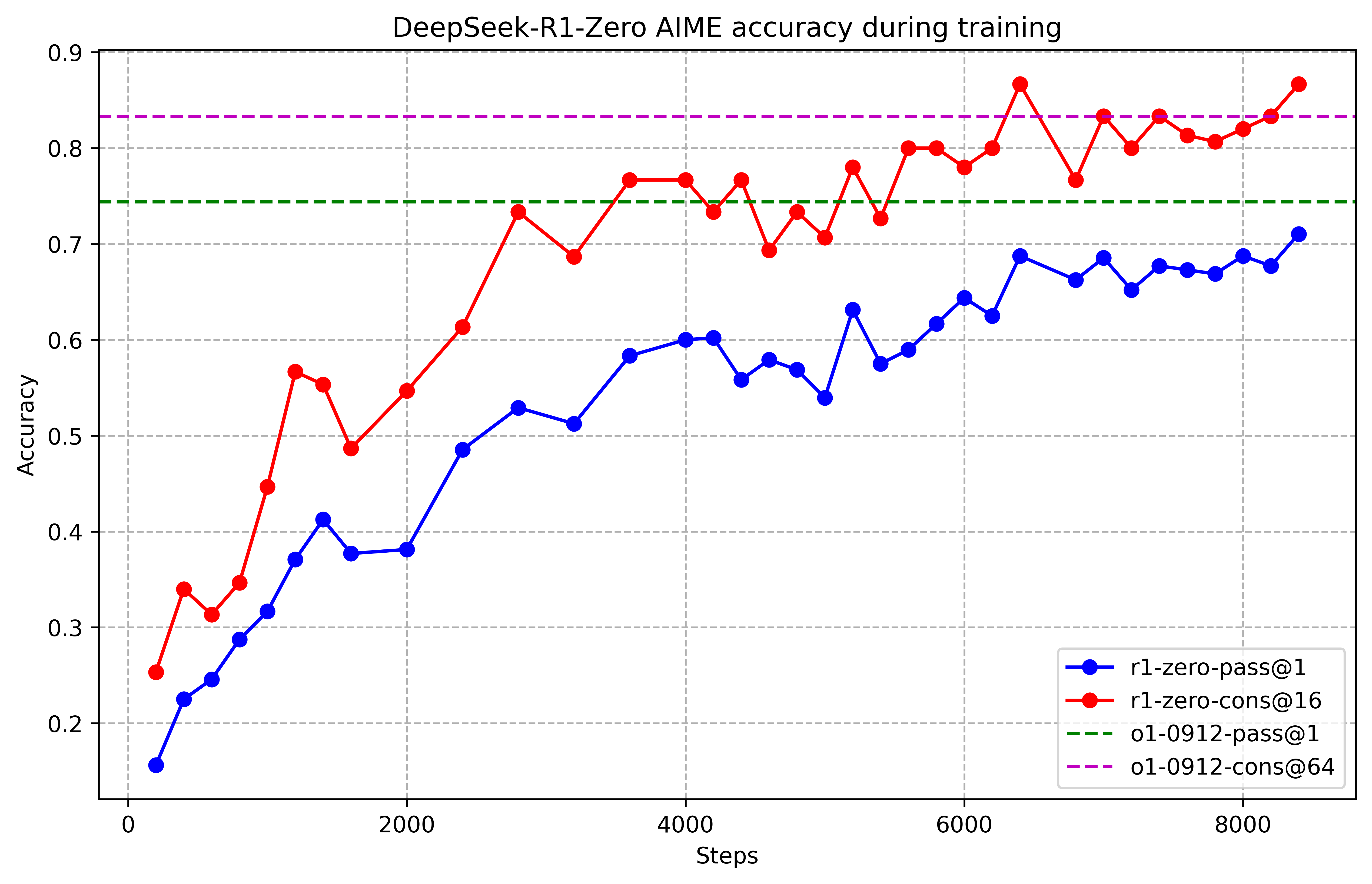

Рис.2. Точность AIME DeepSeek-R1-Zero во время обучения. Для каждого вопроса выбирается 16 ответов и вычисляем общую среднюю точность, чтобы обеспечить стабильную оценку.

На рисунке 2 показана динамика изменения результатов модели DeepSeek-R1-Zero на тесте AIME 2024 в процессе обучения с подкреплением. Как видно из графика, по мере продвижения обучения модель демонстрирует устойчивый рост производительности. Особенно заметно увеличение среднего значения метрики pass@1 — она вырастает с начальных 15,6% до впечатляющих 71,0%, что выводит модель на уровень, сравнимый с OpenAI-o1-0912. Это значительное улучшение демонстрирует высокую эффективность используемого алгоритма обучения с подкреплением.

В таблице 1 представлено сравнение характеристик DeepSeek-R1-Zero и модели OpenAI o1-0912 на различных задачах, связанных с логическими рассуждениями. Выяснилось, что обучение с подкреплением позволяет DeepSeek-R1-Zero достичь высокого уровня рассуждающей способности без использования каких-либо данных для тонкой настройки в режиме учителя. Этот результат важен сам по себе, поскольку он показывает, что модель может эффективно учиться и обобщать информацию исключительно за счёт RL. Более того, эффективность модели можно дополнительно повысить с помощью метода большинства голосов (majority voting). Например, при его применении на тесте AIME результаты DeepSeek-R1-Zero возрастают с 71,0% до 86,7%, превосходя таким образом показатель OpenAI-o1-0912. Способность модели достигать таких высоких результатов как без дополнительных методов, так и с их использованием подчёркивает её сильную архитектурную основу и потенциал для дальнейшего развития в области решения задач на рассуждение.

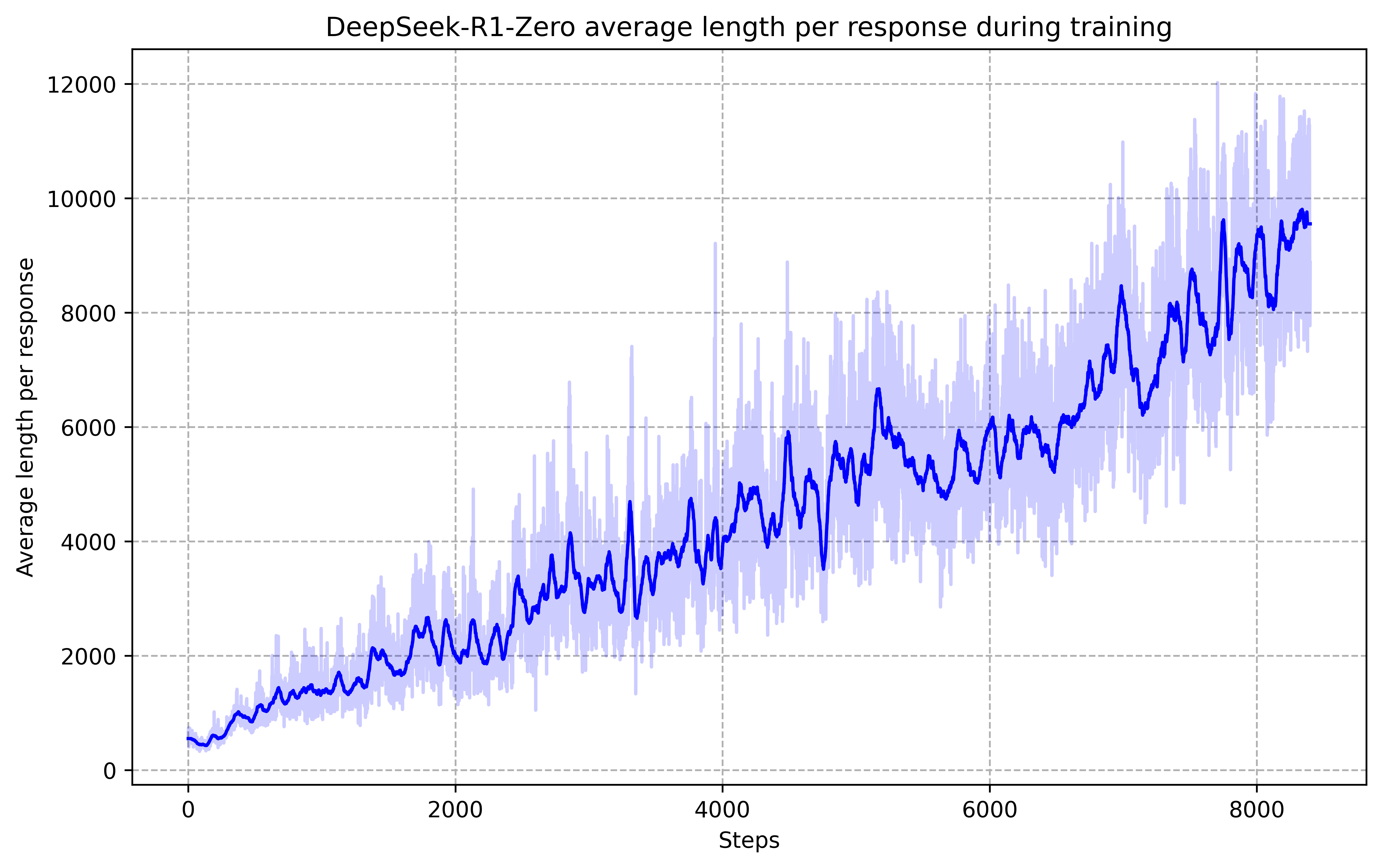

Рис.3. Средняя длина ответа DeepSeek-R1-Zero на обучающем наборе во время процесса RL. DeepSeek-R1-Zero естественным образом учится решать задачи на рассуждение, тратя больше времени на обдумывание.

Процесс самоэволюции модели DeepSeek-R1-Zero демонстрирует, как обучение с подкреплением (RL) может способствовать автономному улучшению способностей к логическим рассуждениям. Исследователи начали RL непосредственно с базовой модели, без предварительной дообучения на размеченных данных, чтобы исключить влияние этого этапа и более точно отслеживать естественное развитие модели. Такой подход позволил получить чёткое представление о том, как модель совершенствуется со временем, особенно в решении сложных логических задач.

Как показано на рисунке 3, время, затрачиваемое моделью на размышления, стабильно увеличивается в ходе обучения. Это улучшение является результатом внутренних изменений в модели, а не внешних корректировок. В процессе эволюции DeepSeek-R1-Zero постепенно развивает способность решать всё более сложные задачи за счёт увеличения вычислительных ресурсов на этапе тестирования (те увеличения длины генерации на инференсе). Объём рассуждений, генерируемых моделью, вырастает от сотен до тысяч токенов, что позволяет ей глубже исследовать и уточнять свои логические цепочки.

Одним из наиболее примечательных явлений, возникших в ходе самоэволюции, стало появление сложных поведенческих паттернов при увеличении вычислительных мощностей на этапе тестирования. Например, модель самостоятельно начинает перепроверять и переоценивать свои предыдущие шаги (рефлексия), а также пробовать различные подходы к решению задач. Эти стратегии не были заложены в модель искусственно — они сформировались спонтанно в результате взаимодействия с окружением обучения с подкреплением. Такая самопроизвольная адаптация значительно усиливает способности модели к логическому мышлению, позволяя ей эффективнее и точнее справляться с трудными задачами.

Одним из особенно интересных явлений, наблюдавшихся в ходе обучения модели DeepSeek-R1-Zero, стало появление так называемого «момента озарения» (Aha Moment). Этот феномен был зафиксирован на этапе промежуточной версии модели и продемонстрирован в таблице 2. В этот момент модель начинает выделять больше времени на решение задачи, пересматривая свой первоначальный подход. Такое поведение не только свидетельствует о росте её способностей к логическим рассуждениям, но и наглядно показывает, как обучение с подкреплением может приводить к неожиданным и сложным результатам.

Question: If a>1, then the sum of the real solutions of a−a+x=x is equal to

Response: <think>

To solve the equation a−a+x=x, let’s start by squaring both ⋯

(a−a+x)2=x2⟹a−a+x=x2.

Rearrange to isolate the inner square root term:

(a−x2)2=a+x⟹a2−2ax2+(x2)2=a+x⟹x4−2ax2−x+(a2−a)=0

…

Wait, wait. Wait. That’s an aha moment I can flag here.

Let’s reevaluate this step-by-step to identify if the correct sum can be ⋯

We started with the equation:

a−a+x=x

First, let’s square both sides:

a−a+x=x2⟹a+x=a−x2

Next, I could square both sides again, treating the equation: ⋯

…Таблица 2. Aha Moment

Этот момент стал настоящим открытием не только для самой модели, но и для исследователей, следивших за её развитием. Он демонстрирует силу и элегантность метода обучения с подкреплением: вместо того чтобы заранее задавать стратегию решения задач, учёные просто создали правильные условия и стимулы, после чего модель самостоятельно разработала эффективные подходы к решению проблем. «Момент озарения» напоминает о громадном потенциале RL в раскрытии новых уровней интеллекта в искусственных системах и открывает путь к созданию более автономных и адаптивных моделей в будущем.

Недостатки DeepSeek-R1-Zero

Несмотря на то, что DeepSeek-R1-Zero обладает сильными способностями к логическим рассуждениям и формирует неожиданно эффективные и сложные стратегии самостоятельно, у модели имеются некоторые недостатки. Среди них — проблемы с читаемостью вывода и смешение языков в ответах. Для улучшения понятности рассуждений и возможности делиться ими с научным сообществом, исследователи обратились к методу DeepSeek-R1, который использует обучение с подкреплением совместно с данными холодного старта, ориентированными на восприятие человеком.

DeepSeek-R1: Обучение с подкреплением с использованием «холодного старта»

Вдохновлённые успешными результатами модели DeepSeek-R1-Zero, исследователи задались двумя естественными вопросами:

- Можно ли дополнительно улучшить способность к рассуждению или ускорить процесс сходимости обучения, если добавить в начало небольшое количество высококачественных данных (так называемый «холодный старт»)?

- Как обучить модель, удобную для пользователя, которая не только генерирует чёткие и логичные цепочки рассуждений (Chains of Thought, CoT), но и обладает сильными общими способностями?

Для ответа на эти вопросы была разработана четырёхэтапная методика обучения модели DeepSeek-R1. Основные этапы приведены ниже.

Холодный старт

В отличие от DeepSeek-R1-Zero, где обучение начинается с нуля, в случае DeepSeek-R1 исследователи решили использовать небольшой набор данных с длинными цепочками рассуждений, чтобы дообучить исходную модель перед началом RL-обучения. Это помогло избежать нестабильности на ранних этапах обучения с подкреплением. Для сбора таких данных было опробовано несколько подходов:

- использование few-shot-примеров с длинными CoT,

- побуждение модели генерировать детализированные ответы с рефлексией и проверкой,

- сборка выходных данных модели DeepSeek-R1-Zero в удобочитаемом формате,

- а также доработка результатов с помощью постобработки, осуществляемой людьми.

В рамках проекта было собрано несколько тысяч примеров холодного старта, которые использовались для дообучения модели DeepSeek-V3-Base — она стала отправной точкой для дальнейшего RL-обучения. По сравнению с DeepSeek-R1-Zero, холодный старт даёт следующие преимущества:

-

Читаемость: Одним из ключевых недостатков DeepSeek-R1-Zero является то, что её выводы часто бывают плохо структурированы и трудны для восприятия. Ответы могут содержать смесь языков или отсутствие разметки, выделяющей ключевые фрагменты. При создании данных для холодного старта DeepSeek-R1 исследователи уделяли особое внимание читаемости: каждый ответ завершается кратким резюме, а также фильтруются те ответы, которые не соответствуют требованиям удобства для пользователя. Формат вывода был зафиксирован как |special_token|<цепочка_рассуждений>|special_token|<резюме>, где первая часть содержит CoT-рассуждение, а вторая — его краткое содержание.

-

Потенциал: Благодаря тщательно разработанной структуре холодного старта, основанной на человеческом опыте, удалось добиться более высоких результатов по сравнению с DeepSeek-R1-Zero. Исследователи полагают, что итеративное обучение — это более эффективный путь развития моделей, способных к логическим рассуждениям.

Обучение с акцентом на рассуждения

После дообучения модели DeepSeek-V3-Base на данных начального этапа (cold start), исследователи применяют тот же процесс масштабного обучения с подкреплением, что и в случае DeepSeek-R1-Zero. Основная цель этой фазы — улучшение способности модели к логическим рассуждениям, особенно в задачах, требующих аналитического подхода: программирование, математика, наука и логические головоломки, где существуют чётко определённые условия и решения.

В ходе обучения было замечено, что цепочки рассуждений (Chain-of-Thought, CoT) часто содержат смешение языков, особенно при использовании многоязычных запросов. Чтобы решить эту проблему, авторы добавили специальный штрафной сигнал — награду за языковую согласованность, которая рассчитывается как доля слов, написанных на целевом языке в цепочке рассуждений. Хотя эксперименты показали небольшое снижение общей эффективности модели, такой подход лучше соответствует предпочтениям людей — вывод становится более понятным и читаемым.

Итоговая функция награды формировалась простым сложением двух компонент: точности выполнения рассуждающих задач и коэффициента языковой согласованности. После этого модель обучалась с подкреплением до тех пор, пока не достигла стабильных результатов на тестовых задачах, связанных с рассуждениями.

Отбор образцов и дообучение с учителем

Когда модель завершила этап обучения с подкреплением, ориентированный на рассуждения, исследователи использовали полученную версию модели для сбора данных для следующего этапа — обучения с учителем (Supervised Fine-Tuning, SFT). В отличие от начального этапа, сосредоточенного исключительно на задачах рассуждения, эта фаза направлена на развитие других навыков: письма, ролевой игры (role play) и общих коммуникативных способностей.

Для этого этапа данные формировались следующим образом:

Данные, связанные с рассуждениями

Исследователи собрали запросы, направленные на проверку логики и аналитики, и генерировали возможные цепочки рассуждений, используя метод отбора (rejection sampling) из уже обученной RL-модели. На предыдущем этапе в выборку попадали только те примеры, которые можно было оценить с помощью заранее заданных правил. На этом этапе набор данных был расширен за счёт использования генеративной модели оценки: эталонные ответы и прогнозы модели подавались на вход DeepSeek-V3, который сам оценивал качество.

Также была проведена фильтрация: убирались цепочки рассуждений со смешением языков, слишком длинные абзацы и блоки кода, которые могли затруднять восприятие. Для каждого запроса генерировалось несколько ответов, из которых сохранялись только корректные. Общее количество примеров, связанных с рассуждениями, составило около 600 тысяч.

Данные, не связанные с рассуждениями

Для задач, не требующих аналитической работы — таких как письмо, фактологические вопросы, картина мира или перевод — использовался уже готовый пайплайн и часть обучающего набора DeepSeek-V3. Для некоторых нетривиальных, но не строго логических задач вызывалась модель DeepSeek-V3, чтобы сгенерировать промежуточное рассуждение перед ответом. Однако для простых приветственных сообщений вроде «привет» цепочка рассуждений не использовалась. Общий объём этих данных составил около 200 тысяч примеров.

Финальная модель DeepSeek-V3-Base дообучалась на собранном наборе из ~800 тысяч примеров в течение двух эпох.

Обучение с подкреплением для всех сценариев

Чтобы ещё больше привести модель в соответствие с предпочтениями пользователей, исследователи провели второй этап обучения с подкреплением. Его цель — повысить полезность и безопасность модели, одновременно улучшая её рассуждающие способности.

Модель обучалась на основе комбинации различных сигналов вознаграждения и разнообразных типов запросов. Для задач, связанных с рассуждениями, применялись правила, аналогичные тем, что использовались в DeepSeek-R1-Zero — то есть жёсткие метрики оценки правильности решений в математике, программировании и логике. Для более общих задач, где важны субъективные факторы, использовались модели вознаграждения, способные оценивать ответы по критериям, близким к человеческим.

На этапе оценки полезности внимание уделялось в первую очередь итоговой части ответа — резюме, чтобы подчеркнуть его ценность и уместность. При оценке безопасности анализировался весь ответ полностью — включая цепочку рассуждений и финальный ответ — чтобы выявить потенциальные ошибки, предвзятости или вредоносное содержание.

В результате интеграции различных источников вознаграждений и разнообразия обучающих данных удалось создать модель, которая демонстрирует высокий уровень в задачах на рассуждение, одновременно оставаясь полезной, безопасной и соответствующей ожиданиям пользователей.

Дистилляция: наделение маленьких моделей способностью к рассуждениям

Чтобы наделить более эффективные, компактные модели способностями к логическому мышлению, подобными DeepSeek-R1, исследователи непосредственно тонко настраивали открытые модели, такие как Qwen (Qwen, 2024b) и Llama (AI@Meta, 2024), используя 800 тыс. отобранных с помощью DeepSeek-R1 примеров, как описано выше. Их результаты показывают, что этот простой метод дистилляции значительно улучшает способность к рассуждениям маленьких моделей. В качестве базовых моделей использовались Qwen2.5-Math-1.5B, Qwen2.5-Math-7B, Qwen2.5-14B, Qwen2.5-32B, Llama-3.1-8B и Llama-3.3-70B-Instruct. Llama-3.3 была выбрана потому, что её способность к рассуждениям немного превосходит такую у Llama-3.1.

Для дистиллированных моделей применяли только обучение с подкреплением (SFT), не включая этап RL, хотя включение RL могло бы существенно повысить производительность модели. Основной целью здесь было продемонстрировать эффективность метода дистилляции, а дальнейшие исследования этапа RL были оставлены для более широкого научного сообщества.

Эксперименты

Бенчмарки

Исследователи оценили модели на следующих бенчмарках:

- MMLU (Hendrycks et al., 2020),

- MMLU-Redux (Gema et al., 2024),

- MMLU-Pro (Wang et al., 2024),

- C-Eval (Huang et al., 2023),

- CMMLU (Li et al., 2023),

- IFEval (Zhou et al., 2023),

- FRAMES (Krishna et al., 2024),

- GPQA Diamond (Rein et al., 2023),

- SimpleQA (OpenAI, 2024c),

- C-SimpleQA (He et al., 2024),

- SWE-Bench Verified (OpenAI, 2024d),

- Aider1 [1],

- LiveCodeBench (Jain et al., 2024) (2024-08 – 2025-01),

- Codeforces2,

- китайской национальной олимпиаде по математике для старших классов (CNMO 2024),

- а также на American Invitational Mathematics Examination 2024 (AIME 2024) (MAA, 2024).

В дополнение к стандартным бенчмаркам, исследователи оценивали свои модели на задачах с открытым ответом, используя LLM в качестве судей. Конкретно, они придерживались исходных конфигураций AlpacaEval 2.0 (Dubois et al., 2024) и Arena-Hard (Li et al., 2024), которые используют GPT-4-Turbo-1106 в качестве судьи для попарного сравнения. Здесь исследователи подавали только финальный резюме на оценку, чтобы избежать смещения из-за длины текста. Для дистиллированных моделей были проведены оценки на AIME 2024, MATH-500, GPQA Diamond, Codeforces и LiveCodeBench.

Оценочные промпты

Следуя настройке DeepSeek-V3, стандартные бенчмарки, такие как MMLU, DROP, GPQA Diamond и SimpleQA, оценивались с использованием запросов из фреймворка simple-evals.

Для MMLU-Redux применялся формат Zero-Eval (Lin, 2024) в zero-shot режиме.

Что касается MMLU-Pro, C-Eval и CLUE-WSC, где оригинальные запросы являются few-shot, исследователи немного адаптировали их под zero-shot.

Цепочки рассуждений (CoT) в few-shot могут негативно повлиять на производительность DeepSeek-R1.

Другие наборы данных оценивались согласно их оригинальным протоколам с дефолтными запросами, предоставленными авторами.

Для кодирования и математических бенчмарков набор HumanEval-Mul охватывает восемь популярных языков программирования: Python, Java, C++, C#, JavaScript, TypeScript, PHP и Bash. Производительность моделей на LiveCodeBench оценивалась с использованием формата CoT, данные собирались с августа 2024 по январь 2025 года. Набор Codeforces был оценен с помощью задач из 10 контестов Div.2 и экспертно составленных тестовых случаев, после чего рассчитывались ожидаемые рейтинги и процент участников. Результаты SWE-Bench проверялись через framework без агентов (Xia et al., 2024). Бенчмарки, связанные с AIDER, измерялись с использованием формата "diff". Выходы DeepSeek-R1 ограничивались максимальным количеством токенов в 32 768 для каждого бенчмарка.

Baselines

Для всесторонней оценки исследователи сравнивали свои модели с несколькими сильными базовыми моделями, включая DeepSeek-V3, Claude-Sonnet-3.5-1022, GPT-4o-0513, OpenAI-o1-mini и OpenAI-o1-1217. Поскольку доступ к API OpenAI-o1-1217 затруднён в Китае, его производительность была оценена на основе официальных отчётов. Для дистиллированных моделей исследователи также проводили сравнение с открытой моделью QwQ-32B-Preview (Qwen, 2024a).

Evaluation Setup

Максимальная длина генерации устанавливалась в 32 768 токенов для всех моделей. Исследователи обнаружили, что использование жадного декодирования для оценки моделей с длительным выводом приводит к высокой частоте повторов и значительному разбросу результатов между различными чекпоинтами. Поэтому по умолчанию использовался метод pass@k (Chen et al., 2021), и результаты pass@1 были получены с ненулевой температурой. Конкретно, температура выборки составляла 0.6, а значение top-p — 0.95. Для каждой задачи генерировалось \(k\) ответов (обычно от 4 до 64, в зависимости от размера тестового набора), после чего вычислялось:

\[ \text{pass@1} = \frac{1}{k} \sum_{i=1}^{k} p_i,\]

где \(p_i\) обозначает корректность \(i\)-го ответа. Этот метод обеспечивает более надёжную оценку производительности. Для AIME 2024 также были представлены результаты консенсуса (мажоритарного голосования) (Wang et al., 2022) с использованием 64 образцов, обозначенных как cons@64.

| DeepSeek-R1 Evaluation | Benchmark (Metric) | Claude-3.5-Sonnet-1022 | GPT-4o-0513 | DeepSeek-V3 | OpenAI-o1-mini | OpenAI-o1-1217 | DeepSeek-R1 |

|---|---|---|---|---|---|---|---|

| Architecture | - | - | MoE | - | - | MoE | |

| # Activated Params | - | - | 37B | - | - | 37B | |

| # Total Params | - | - | 671B | - | - | 671B | |

| English | MMLU (Pass@1) | 88.3 | 87.2 | 88.5 | 85.2 | 91.8 | 90.8 |

| MMLU-Redux (EM) | 88.9 | 88.0 | 89.1 | 86.7 | - | 92.9 | |

| MMLU-Pro (EM) | 78.0 | 72.6 | 75.9 | 80.3 | - | 84.0 | |

| DROP (3-shot F1) | 88.3 | 83.7 | 91.6 | 83.9 | 90.2 | 92.2 | |

| IF-Eval (Prompt Strict) | 86.5 | 84.3 | 86.1 | 84.8 | - | 83.3 | |

| GPQA Diamond (Pass@1) | 65.0 | 49.9 | 59.1 | 60.0 | 75.7 | 71.5 | |

| SimpleQA (Correct) | 28.4 | 38.2 | 24.9 | 7.0 | 47.0 | 30.1 | |

| FRAMES (Acc.) | 72.5 | 80.5 | 73.3 | 76.9 | - | 82.5 | |

| AlpacaEval2.0 (LC-winrate) | 52.0 | 51.1 | 70.0 | 57.8 | - | 87.6 | |

| ArenaHard (GPT-4-1106) | 85.2 | 80.4 | 85.5 | 92.0 | - | 92.3 | |

| Code | LiveCodeBench (Pass@1-COT) | 38.9 | 32.9 | 36.2 | 53.8 | 63.4 | 65.9 |

| Codeforces (Percentile) | 20.3 | 23.6 | 58.7 | 93.4 | 96.6 | 96.3 | |

| Codeforces (Rating) | 717 | 759 | 1134 | 1820 | 2061 | 2029 | |

| SWE Verified (Resolved) | 50.8 | 38.8 | 42.0 | 41.6 | 48.9 | 49.2 | |

| Aider-Polyglot (Acc.) | 45.3 | 16.0 | 49.6 | 32.9 | 61.7 | 53.3 | |

| Math | AIME 2024 (Pass@1) | 16.0 | 9.3 | 39.2 | 63.6 | 79.2 | 79.8 |

| MATH-500 (Pass@1) | 78.3 | 74.6 | 90.2 | 90.0 | 96.4 | 97.3 | |

| CNMO 2024 (Pass@1) | 13.1 | 10.8 | 43.2 | 67.6 | - | 78.8 | |

| Chinese | CLUEWSC (EM) | 85.4 | 87.9 | 90.9 | 89.9 | - | 92.8 |

| C-Eval (EM) | 76.7 | 76.0 | 86.5 | 68.9 | - | 91.8 | |

| C-SimpleQA (Correct) | 55.4 | 58.7 | 68.0 | 40.3 | - | 63.7 |

Таблица 3. Сравнение DeepSeek-R1 с другими репрезентативными моделями.

В образовательно ориентированных тестах на знания, таких как MMLU, MMLU-Pro и GPQA Diamond, DeepSeek-R1 показывает более высокую производительность по сравнению с DeepSeek-V3. Это улучшение в первую очередь связано с повышением точности при ответе на вопросы, связанные с естественными науками, где значительные результаты достигаются благодаря использованию масштабного обучения с подкреплением. Кроме того, DeepSeek-R1 демонстрирует выдающиеся результаты на FRAMES — задаче QA, зависящей от длинного контекста, что свидетельствует о его сильных способностях к анализу документов. Это подчеркивает потенциал моделей рассуждений в задачах поиска и анализа данных, управляемых искусственным интеллектом. На фактическом бенчмарке SimpleQA DeepSeek-R1 превосходит DeepSeek-V3, демонстрируя свою способность обрабатывать запросы, основанные на фактах. Похожая тенденция наблюдается, когда OpenAI-o1 превосходит GPT-4o на этом бенчмарке. Однако DeepSeek-R1 хуже справляется с китайским вариантом SimpleQA, главным образом из-за своей склонности отказываться от ответа на определенные запросы после применения безопасного RL. Без ограничений безопасности DeepSeek-R1 может достичь точности более 70%.

DeepSeek-R1 также демонстрирует впечатляющие результаты на IF-Eval — бенчмарке, разработанном для оценки способности модели следовать форматным инструкциям. Эти улучшения можно связать с включением данных, связанных с выполнением инструкций, на заключительных этапах обучения с учителем (SFT) и обучения с подкреплением (RL). Более того, выдающаяся производительность наблюдается на AlpacaEval2.0 и ArenaHard, что указывает на сильные стороны DeepSeek-R1 в задачах написания текстов и открытого вопроса. Его существенное превосходство над DeepSeek-V3 подчеркивает преимущества масштабного RL в обобщении, которое не только усиливает способности к рассуждению, но и улучшает эффективность в различных областях. Более того, длина сводок, генерируемых DeepSeek-R1, является лаконичной, в среднем составляя 689 токенов на ArenaHard и 2218 символов на AlpacaEval 2.0. Это свидетельствует о том, что DeepSeek-R1 избегает введения смещения по длине во время оценок на основе GPT, дополнительно укрепляя свою устойчивость во множестве задач.

На математических задачах DeepSeek-R1 демонстрирует уровень производительности, сравнимый с OpenAI-o1-1217, значительно превосходя другие модели. Похожая тенденция наблюдается на задачах алгоритмического программирования, таких как LiveCodeBench и Codeforces, где доминируют модели, ориентированные на рассуждение. На инженерно-ориентированных задачах программирования OpenAI-o1-1217 превосходит DeepSeek-R1 на Aider, но обеспечивает сопоставимую производительность на SWE Verified. Мы полагаем, что инженерная производительность DeepSeek-R1 улучшится в следующей версии, поскольку объем связанных данных RL-обучения на данный момент остается очень ограниченным.

| Model | AIME 2024 | MATH-500 | GPQA | LiveCode | CodeForces | Diamond Bench |

|---|---|---|---|---|---|---|

| pass@1 | cons@64 | pass@1 | pass@1 | pass@1 | rating | |

| GPT-4o-0513 | 9.3 | 13.4 | 74.6 | 49.9 | 32.9 | 759 |

| Claude-3.5-Sonnet-1022 | 16.0 | 26.7 | 78.3 | 65.0 | 38.9 | 717 |

| OpenAI-o1-mini | 63.6 | 80.0 | 90.0 | 60.0 | 53.8 | 1820 |

| QwQ-32B-Preview | 50.0 | 60.0 | 90.6 | 54.5 | 41.9 | 1316 |

| DeepSeek-R1-Distill-Qwen-1.5B | 28.9 | 52.7 | 83.9 | 33.8 | 16.9 | 954 |

| DeepSeek-R1-Distill-Qwen-7B | 55.5 | 83.3 | 92.8 | 49.1 | 37.6 | 1189 |

| DeepSeek-R1-Distill-Qwen-14B | 69.7 | 80.0 | 93.9 | 59.1 | 53.1 | 1481 |

| DeepSeek-R1-Distill-Qwen-32B | 72.6 | 83.3 | 94.3 | 62.1 | 57.2 | 1691 |

| DeepSeek-R1-Distill-Llama-8B | 50.4 | 80.0 | 89.1 | 49.0 | 39.6 | 1205 |

| DeepSeek-R1-Distill-Llama-70B | 70.0 | 86.7 | 94.5 | 65.2 | 57.5 | 1633 |

Таблица 4. Сравнение дистилированных из DeepSeek-R1 моделей и других сопоставимых моделей по тестам, связанным с рассуждениями.

Как показано в Таблице 4, простая дистилляция выходных данных DeepSeek-R1 позволяет эффективному дистилированному варианту DeepSeek-R1-7B (т. е. DeepSeek-R1-Distill-Qwen-7B) превосходить non-reasoning модели, такие как GPT-4o-0513, по всем указанным бенчмаркам. DeepSeek-R1-14B превосходит QwQ-32B-Preview по всем оценочным показателям, в то время как DeepSeek-R1-32B и DeepSeek-R1-70B значительно превосходят o1-mini по большинству тестов.

Эти результаты демонстрируют большой потенциал дистилляции. Кроме того, исследователи обнаружили, что применение RL к этим дистиллированным моделям дает значительный дополнительный прирост. Это требует дальнейшего изучения, и поэтому в открытый доступ выложены только результаты простых моделей, дистиллированных SFT.

Distillation vs Reinforcement Learning

| Model | AIME 2024 | MATH-500 | GPQA Diamond | LiveCodeBench |

|---|---|---|---|---|

| pass@1 | cons@64 | pass@1 | pass@1 | |

| QwQ-32B-Preview | 50.0 | 60.0 | 90.6 | 54.5 |

| DeepSeek-R1-Zero-Qwen-32B | 47.0 | 60.0 | 91.6 | 55.0 |

| DeepSeek-R1-Distill-Qwen-32B | 72.6 | 83.3 | 94.3 | 62.1 |

Таблица 5. Сравнение дистиллированных и RL-моделей по показателям, связанным с рассуждениями

Как можно увидеть, за счёт дистилляции DeepSeek-R1 маленькие модели демонстрирует впечатляющие результаты. Однако остаётся один вопрос: может ли модель достичь сравнимой производительности с помощью масштабного обучения с подкреплением, описанного в статье, без применения дистилляции?

Чтобы ответить на этот вопрос, исследователи проводят масштабное обучение с подкреплением модели Qwen-32B-Base с использованием данных по математике, кодированию и STEM, тренируя её более 10 тысяч шагов. В результате получают модель DeepSeek-R1-Zero-Qwen-32B. Экспериментальные данные, приведённые в таблице 5, показывают, что базовая модель объёмом 32B, прошедшая масштабное обучение с подкреплением, достигает уровня производительности, сравнимого с QwQ-32B-Preview. При этом DeepSeek-R1-Distill-Qwen-32B, которая была дистиллирована из DeepSeek-R1, значительно превосходит DeepSeek-R1-Zero-Qwen-32B по всем тестовым метрикам.

Таким образом, можно сделать два вывода: во-первых, дистилляция более мощных моделей в меньшие даёт отличные результаты, тогда как для менее ёмких моделей, опирающихся на масштабное обучение с подкреплением, требуются огромные вычислительные ресурсы, и они могут не достичь даже уровня дистиллированных моделей. Во-вторых, хотя стратегии дистилляции экономичны и эффективны, выход за рамки текущих возможностей интеллекта всё ещё может потребовать более мощных базовых моделей и более масштабного обучения с подкреплением.

Неудачные попытки

На ранних этапах разработки DeepSeek-R1 исследователи столкнулись с рядом неудач и трудностей.

Модель процессной награды (Process Reward Model - PRM)

PRM — это обоснованный метод, направленный на руководство моделью к лучшим способам решения задач рассуждения (Uesato et al., 2022; Lightman et al., 2023; Wang et al., 2023). Однако на практике PRM имеет три основных ограничения, которые могут препятствовать её успеху. Во-первых, сложно чётко определить мелкие шаги в общем процессе рассуждения. Во-вторых, определение правильности промежуточного шага представляет собой сложную задачу. Автоматическая аннотация с помощью моделей может не дать удовлетворительных результатов, а ручная аннотация не способствует масштабированию. В-третьих, при введении моделирующей PRM неизбежно возникает проблема хакинга награды (Gao et al., 2022), а перетренировка модели награды требует дополнительных ресурсов и усложняет всю цепочку обучения. В заключение, хотя PRM демонстрирует хорошую способность переупорядочивать верхние N ответов, сгенерированных моделью, или помогать в управляемом поиске (Snell et al., 2024), её преимущества ограничены по сравнению с дополнительными вычислительными затратами, которые она вносит в процесс масштабного обучения с подкреплением в экспериментах исследователей.

Поиск с использованием метода Монте-Карло (Monte Carlo Tree Search - MCTS)

Вдохновлённые AlphaGo (Silver et al., 2017b) и AlphaZero (Silver et al., 2017a), исследователи изучали применение метода Монте-Карло (MCTS) для повышения масштабируемости вычислений на этапе тестирования. Этот подход предполагает разбиение ответов на более мелкие части, позволяя модели систематически исследовать пространство решений. Для этого модели задавались подсказки, побуждающие генерировать несколько тегов, соответствующих конкретным шагам рассуждений, необходимым для поиска. На этапе обучения сначала использовались собранные запросы для поиска ответов с помощью MCTS, контролируемого предварительно обученной моделью значений. Затем применялись полученные пары вопрос-ответ для обучения как актерской модели, так и модели значений, последовательно улучшая весь процесс.

Однако при масштабировании обучения этот подход сталкивается с рядом трудностей. Во-первых, в отличие от шахмат, где пространство поиска довольно чётко определено, генерация токенов представляет собой экспоненциально большее пространство поиска. Чтобы справиться с этим, исследователи устанавливали максимальный лимит расширения для каждого узла, но это может привести к тому, что модель застрянет в локальных минимумах. Во-вторых, модель значений напрямую влияет на качество генерации, поскольку она направляет каждый шаг процесса поиска. Обучение детализированной модели значений по своей сути является сложной задачей, что затрудняет итеративное улучшение модели. Хотя ключевой успех AlphaGo был обеспечен обучением модели значений для постепенного повышения её производительности, эта концепция оказалась сложной для воспроизведения в данном случае из-за сложности генерации токенов.

В заключение, хотя MCTS может улучшить производительность модели при наличии предварительно обученной модели значений, итеративное повышение её эффективности через самопоиск остаётся значительным вызовом.

Заключение

DeepSeek-R1-Zero представляет собой чистый подход RL, не зависящий от холодных данных, и демонстрирует высокую производительность на различных задачах. DeepSeek-R1 более мощна, используя холодные данные вместе с итеративным тонким настройкой RL. В конечном итоге, DeepSeek-R1 достигает уровня производительности, сравнимого с OpenAI-o1-1217, на ряде задач.

Исследователи также изучили возможность передачи способности к рассуждению на небольшие плотные модели. Они используют DeepSeek-R1 в качестве учителя для генерации 800 тыс. образцов обучения и тонко настраивают несколько небольших плотных моделей. Результаты обнадёживающие: DeepSeek-R1-Distill-Qwen-1.5B превосходит GPT-4o и Claude-3.5-Sonnet на математических тестах с результатами 28,9% на AIME и 83,9% на MATH. Другие плотные модели также показывают впечатляющие результаты, значительно превосходя другие модели, обученные на тех же исходных контрольных точках.

В будущем планируется развитие следующих направлений исследований для DeepSeek-R1:

-

Общая функциональность: На данный момент возможности DeepSeek-R1 уступают DeepSeek-V3 в задачах, таких как вызовы функций, многоходовые диалоги, сложное ролевое взаимодействие и формат JSON. В дальнейшем планируется изучить, как длинные цепочки рассуждений могут быть использованы для улучшения этих направлений.

-

Смешивание языков: DeepSeek-R1 оптимизирована для китайского и английского языков, что может приводить к смешению языков при обработке запросов на других языках. Например, DeepSeek-R1 может использовать английский язык для рассуждений и ответов, даже если запрос представлен на другом языке, отличном от английского или китайского. Это ограничение будет решаться в будущих обновлениях.

-

Проектирование подсказок: При оценке DeepSeek-R1 было замечено, что модель чувствительна к подсказкам. Применение few-shot prompting постоянно снижает её производительность. Поэтому рекомендуется пользователям прямо описывать проблему и указывать формат вывода в условиях zero-shot для достижения наилучших результатов.

-

Задачи по программированию: Из-за длительного времени оценки, влияющего на эффективность процесса RL, масштабное обучение с подкреплением не применялось широко в задачах программирования. В результате DeepSeek-R1 пока не показывает существенных улучшений по сравнению с DeepSeek-V3 на бенчмарках программирования. В будущих версиях это будет исправлено путём внедрения отбраковки выборки на данных по программированию или включения асинхронной оценки в процесс RL для повышения эффективности.