На пути к большим моделям рассуждений: обзор Reinforced Reasoning with Large Language Models

На основе https://arxiv.org/html/2501.09686v3 Перевод обзора от 01.2025 (до выхода DeepSeek)

Язык давно рассматривается как важный инструмент для человеческого мышления. Прорыв в области больших языковых моделей (LLMs) вызвал значительный исследовательский интерес к использованию этих моделей для решения сложных задач рассуждения. Исследователи пошли дальше простого авторегрессионного генерирования токенов, введя концепцию "мысли" — последовательности токенов, представляющих промежуточные шаги в процессе рассуждения. Этот инновационный подход позволяет LLM имитировать сложные процессы человеческого мышления, такие как поиск по дереву и рефлексивное мышление. В последнее время появилось новое направление в обучении рассуждению, применяющее обучение с подкреплением (RL) для обучения LLM овладению процессами рассуждения. Этот подход позволяет автоматически генерировать высококачественные траектории рассуждений с помощью алгоритмов поиска методом проб и ошибок, значительно расширяя способности LLM к рассуждению за счет предоставления значительно большего объема обучающих данных. Кроме того, недавние исследования показывают, что побуждение LLM "думать" с использованием большего количества токенов во время тестового вывода может значительно повысить точность рассуждений. Таким образом, масштабирование на этапах обучения и тестирования в совокупности открывает новое направление исследований — путь к созданию больших моделей рассуждения. Введение серии o1 от OpenAI знаменует важную веху в этом направлении исследований. В этом обзоре мы представляем всесторонний анализ последних достижений в области рассуждений LLM. Мы начинаем с введения в основополагающие принципы LLM, а затем исследуем ключевые технические компоненты, способствующие развитию больших моделей рассуждения, с акцентом на автоматизированное построение данных, методы обучения рассуждению и масштабирование на этапе тестирования. Мы также анализируем популярные проекты с открытым исходным кодом, направленные на создание больших моделей рассуждения, и заканчиваем обсуждением открытых проблем и будущих направлений исследований.

Благодаря достижениям в области глубокого обучения и доступности веб-масштабных наборов данных, большие языковые модели (LLMs) стали трансформационной парадигмой на пути к искусственному общему интеллекту (AGI). Эти массивные модели ИИ обычно используют архитектуру Трансформер и предварительно обучаются на больших текстовых корпусах с задачей предсказания следующего токена [191]. Закон нейронного масштабирования демонстрирует, что их производительность значительно улучшается по мере увеличения размера модели и объема обучающих данных [59]. Более того, LLM также раскрывают замечательные возникающие способности, отсутствующие в меньших моделях [159], такие как контекстное обучение (few shot in context learning) [33], ролевое моделирование (role play) [124] и рассуждение по аналогии [157]. Эти способности позволяют LLM выходить за рамки задач обработки естественного языка и способствовать более широкому спектру задач, таких как генерация кода [41], робототехническое управление [3] и автономные агенты [28].

Среди этих способностей особое внимание как в академических кругах, так и в индустрии привлекло человекоподобное рассуждение, поскольку оно демонстрирует большой потенциал для LLM в обобщении сложных реальных проблем через абстрактное и логическое мышление. Значительным прорывом в этой области стала техника промптинга CoT Chain-of-Thoughts "цепочка мыслей" [160], которая может вызывать пошаговые процессы человекообразного рассуждения во время инференса без дополнительного обучения. Такие интуитивные техники промтинга доказали свою эффективность в значительном улучшении точности рассуждений предварительно обученных LLM, что также привело к разработке более продвинутых техник промптинга, таких как "дерево мыслей" [172]. Эти подходы вводят концепцию "мысли" как последовательности токенов, представляющих промежуточные шаги в процессе человекообразного рассуждения. Включая такие промежуточные шаги, рассуждения LLM выходят за рамки простого авторегрессионного генерирования токенов, позволяя использовать более сложные когнитивные архитектуры, такие как поиск по дереву [172] и рефлексивное рассуждение [180].

В последнее время наблюдается значительная тенденция в исследованиях, направленных на обучение рассуждению [103], которая стремится обучить LLM овладению процессами человекообразного рассуждения. Основной проблемой в этом направлении исследований является нехватка обучающих данных. Аннотирование человеком часто бывает чрезвычайно дорогим, особенно для пошаговых траекторий рассуждения, которые доказали свою эффективность в обучении рассуждению LLM [75]. Для решения этой проблемы недавние исследования перешли от аннотирования человеком к алгоритмам поиска на основе LLM. Эти подходы используют внешнюю верификацию для задач рассуждения, чтобы автоматически генерировать точные траектории рассуждения через поиск методом проб и ошибок [85]. Более того, исследователи предложили обучать модели вознаграждения процессов (Process Reward Models - PRMs) на этих траекториях рассуждения [183]. PRMs могут предоставлять плотные, пошаговые вознаграждения, которые способствуют обучению с подкреплением для рассуждений LLM. Эти методы в совокупности уменьшают зависимость от данных аннотирования человеком и создают "усиленный цикл" для улучшения рассуждений LLM, эффективно интегрируя "поиск" и "обучение", два метода, которые могут бесконечно масштабироваться, как предсказал Ричард Саттон [139]. Таким образом, эта новая парадигма позволяет масштабировать способности LLM к рассуждению с увеличением вычислительных мощностей на этапе обучения, прокладывая путь к более продвинутым моделям рассуждения.

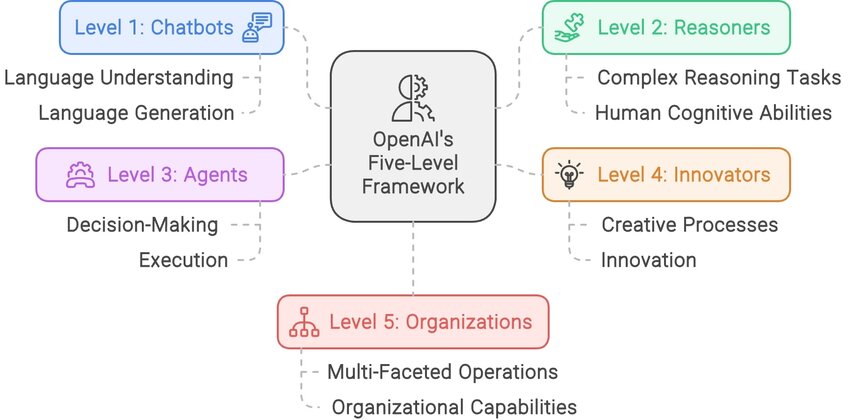

Более того, недавние исследования показывают, что увеличение вычислительных мощностей на этапе тестирования (инференс) также может улучшить точность рассуждений LLM. В частности, PRMs могут использоваться для руководства LLM в оценке и поиске среди промежуточных "мыслей" [134], что побуждает LLM генерировать обдуманные шаги рассуждения во время вычислений на этапе тестирования и повышает точность рассуждений. Этот подход приводит к закону масштабирования на этапе тестирования, который предсказывает, что использование большего количества токенов для обдуманного рассуждения на этапе тестирования может улучшить точность [103]. Таким образом, масштабирование на этапе обучения, управляемое обучением с подкреплением, и масштабирование на этапе тестирования, основанное на поиске, в совокупности показывают многообещающее направление исследований для полного раскрытия способностей LLM к рассуждению, то есть путь к большим моделям рассуждения. Важной вехой в этом направлении исследований является серия o1 от OpenAI [194], которая демонстрирует эффективность этого подхода и отражает видение OpenAI перехода LLM от разговорного ИИ (уровень 1) к более мощному ИИ рассуждений (уровень 2) в пятиступенчатой дорожной карте на пути к AGI [36]. Несколько проектов с открытым исходным кодом, такие как OpenR [145], LLaMA-Berry [185] и Journey Learning [110], посвящены воспроизведению сильных способностей рассуждения OpenAI o1, предоставляя ценные идеи для разработки больших моделей рассуждения.

Рис.1. Open AI's Five Level Framework

В этом обзоре представлен анализ недавних исследовательских усилий в прогрессе к большим моделям рассуждения. Раздел 2 предлагает краткое введение в основы рассуждений LLM. В последующих трех разделах рассматриваются ключевые технические компоненты, способствующие развитию больших моделей рассуждения. В частности, Раздел 3 фокусируется на построении обучающих данных, подчеркивая переход от аннотирования человеком к автоматизированному поиску на основе LLM. Раздел 4 рассматривает методы обучения с подкреплением, которые являются ключевыми для масштабирования способностей LLM к рассуждению с увеличением вычислительных мощностей на этапе обучения, в то время как Раздел 5 обсуждает масштабирование на этапе тестирования с особым акцентом на поиск, управляемый PRM. В Разделе 6 анализируется развитие серии o1 от OpenAI и других проектов с открытым исходным кодом, исследуя путь к большим моделям рассуждения. Раздел 7 суммирует дополнительные техники улучшения на этапе тестирования, а Раздел 8 рассматривает бенчмарки рассуждений. Завершается обзор обсуждением открытых проблем и будущих направлений исследований.

2. Общая информация

2.1 Предобучение

Эффективное предобучение является ключевым этапом в развитии способностей к рассуждению у больших языковых моделей (LLM). Прежде чем обсуждать предобучение для рассуждений LLM, рассмотрим основной процесс общего предобучения LLM. В ходе предобучения LLM не только приобретают базовые лингвистические знания, но и получают разнообразные знания о мире, закладывая прочную основу для появления продвинутых способностей и эффективного соответствия ценностям [191]. Обычно предобучение LLM опирается на высококачественные текстовые корпуса [35, 168], включая обширные коллекции веб-контента, книг, кода и других типов данных. Используя эти богатые текстовые корпуса, LLM строятся на архитектуре трансформеров и обучаются с задачей предсказания следующего токена. После предобучения LLM обычно демонстрируют исключительные способности к контекстному пониманию (in context learning) [14], что позволяет им генерировать связный текст и давать точные ответы на широкий спектр вопросов, используя свою обширную базу знаний. Важно отметить, что этап предобучения играет ключевую роль в развитии способностей LLM к рассуждению. Например, исследования [160] показали, что наборы данных, богатые кодом и математическим контентом, служат ключевой основой для развития устойчивых навыков рассуждения. Следуя этим наблюдениям, вновь разработанные LLM [1] начинают использовать тщательно разработанные синтетические данные для улучшения способностей LLM к рассуждению. Во время предобучения критическим вызовом является балансирование пропорции кода и математических данных с общими текстовыми корпусами для поддержания сильных общих лингвистических способностей при раскрытии потенциала LLM к рассуждению.

2.2 Тонкая настройка (supervised fine tuning - SFT)

Хотя предобучение позволяет LLM демонстрировать способности к рассуждению через контекстное обучение, методы тонкой настройки широко применяются для достижения zero-shot режима и улучшения способностей к рассуждению у LLM. Здесь мы сначала описываем основной процесс тонкой настройки, а затем исследуем его потенциал для улучшения способностей к рассуждению. Как описано в [104], после этапа предобучения LLM вступают в фазу контролируемой тонкой настройки (SFT), также известной как этап настройки инструкций. Основная цель этого этапа — уточнить стиль вывода модели, обеспечивая соответствие ее ответов потребностям человека и реальным приложениям. Это достигается за счет обучения на разнообразных наборах данных с инструкциями, отражающими широкий спектр повседневных человеческих взаимодействий, обычно создаваемых с помощью обширной и тщательно подобранной ручной аннотации и уточнения [195]. С появлением ChatGPT появились новые методы генерации разнообразных наборов данных с инструкциями. К ним относятся техники, которые непосредственно дистиллируют данные из мощных LLM [153, 167], и автоматизированные подходы для крупномасштабного построения наборов данных из существующих корпусов [158, 32]. Используя эти хорошо подготовленные наборы данных для настройки инструкций, процесс тонкой настройки продолжает использовать цель предсказания следующего токена, аналогично предобучению. Однако, в отличие от предобучения, тонкая настройка специально рассчитывает loss только для ответов, обычно игнорируя loss для промптов и вопросов. Кроме того, включение наборов данных, содержащих примеры рассуждений по цепочке мыслей (CoT) [160] и решения математических задач, показало значительное улучшение способностей LLM к рассуждению. Следуя общей практике, большинство текущих подходов используют дистилляцию данных из продвинутых больших моделей рассуждения, за которыми следует тонкая настройка для улучшения способностей LLM к рассуждению для получения окончательных больших моделей рассуждения.

2.3 RL Alignment - Выравнивание через обучение с подкреплением

Полное использование прямой дистилляции данных из продвинутых больших моделей рассуждения ограничивает потенциал новых LLM. Более перспективный подход заключается в использовании обучения с подкреплением для построения данных и обучения моделей, что точно соответствует финальной стадии выравнивания в общем обучении LLM. В общем обучении LLM фаза выравнивания обычно включает методы, такие как обучение с подкреплением на основе обратной связи от человека (RLHF) [104], чтобы направлять модель к генерации контента, соответствующего критериям полезности, безвредности и честности. Цель этой фазы — улучшить безопасность и управляемость LLM в реальности. По сравнению с предыдущей фазой SFT, этот этап обычно включает большое количество тщательно подобранных, вручную размеченных данных ранжирования, чтобы точно отражать человеческие предпочтения [35, 168]. Эти данные включают не только правильные демонстрации, но и нежелательные случаи, которых следует избегать. Стандартный RLHF обычно включает модель SFT, модель вознаграждения и выровненную модель, которые итеративно оптимизируются с помощью методов, таких как PPO [121]. Из-за высоких требований к данным и затрат на обучение стандартного RLHF были предложены методы, такие как прямая оптимизация предпочтений (DPO) [112], чтобы уменьшить зависимость от явных моделей вознаграждения. В DPO loss предпочтений определяется как функция политики для прямого руководства оптимизацией модели. Учитывая многоэтапную природу и сложность задач рассуждения, пост-обучение на основе выравнивания стало последним и наиболее критическим шагом в стимулировании способностей LLM к рассуждению. Путем тщательного разложения процесса рассуждения и постепенной обратной связи с моделью различные методы самообучения [45, 64, 183] на основе обучения с подкреплением и обучения предпочтениям достигли значительного успеха.

2.4 Промпты для продвинутого рассуждения

Человекоподобное рассуждение является одной из самых важных способностей, которые проявляются в LLM с достаточно большими параметрами модели [157]. Хотя zero-shot reasoning может оставаться ненадежным для некоторых задач, исследователи обнаружили различные техники промтов для улучшения этих способностей. Эти техники можно широко разделить на три основных подхода: пошаговое рассуждение (step-by-step reasoning), многопутевое исследование (multi-path exploration) и методы на основе декомпозиции.

Подход пошагового рассуждения, примером которого является подсказка "Цепочка мыслей" [160], демонстрирует, что явное показывание промежуточных шагов рассуждения значительно улучшает способности к решению проблем. Даже простые подсказки, такие как "Давайте думать шаг за шагом", могут эффективно направлять процесс рассуждения [62]. Этот подход был дополнительно уточнен с помощью Self-Consistency [153], который генерирует несколько путей рассуждения для достижения более надежных выводов, и Auto-CoT [189], который автоматизирует генерацию эффективных цепочек рассуждения.

Подходы многопутевого исследования выходят за рамки линейного рассуждения, рассматривая несколько потенциальных путей решения одновременно. "Дерево мыслей" [172] организует альтернативные пути рассуждения в древовидную структуру, позволяя систематически исследовать различные стратегии решения. "Граф мыслей" [11] дополнительно обобщает это до графовой структуры, позволяя более гибкие паттерны рассуждения и возможности возврата. ReAct [173] обогащает эту парадигму, чередуя рассуждения с шагами действий, что позволяет более динамично взаимодействовать с внешними средами.

Для сложных проблем методы на основе декомпозиции оказались особенно эффективными. "Least-to-Most Prompting" [196] и "Algorithm of Thoughts" [122] систематически разбивают сложные проблемы на управляемые компоненты, в то время как "Plan-and-Solve" [147] предоставляет стратегическое руководство для решения этих подзадач. Эти методы особенно ценны при работе с задачами, требующими нескольких шагов или различных уровней анализа.

Эти обширные способности к рассуждению, усиленные структурированными стратегиями промтинга, оказались особенно эффективными для задач, требующих тщательного анализа и систематического мышления, позволяя LLM выполнять широкий спектр сложных социально значимых задач. Успех этих методов демонстрирует, что хотя LLM обладают врожденными способностями к рассуждению, их полный потенциал может быть раскрыт через тщательное руководство и структуру в процессе промтинга.

2.5 Агентный рабочий процесс

Помимо способностей следовать инструкциям и контекстного обучения LLM, исследователи начинают разрабатывать агентные рабочие процессы, которые программируют "паттерны мышления (thinking patterns)" LLM [137]. Такие агентные рабочие процессы позволяют исследователям улучшать способности LLM к рассуждению без дополнительного обучения, но часто требуют больше вычислительных ресурсов на этапе тестирования. Контекстное обучение [33, 25] — это способность улучшать специфическую для задачи производительность LLM, просто предоставляя несколько контекстных демонстраций, что позволяет LLM эффективно обобщать на невиданные проблемы без вычислительно затратного обучения [14]. Хотя происхождение таких способностей остается в значительной степени дискуссионным, недавние исследования предполагают, что контекстное обучение улучшает производительность LLM, позволяя им захватывать пространство меток, распределение входного текста и желаемый формат ответов [97]. Такие желательные особенности позволили исследователям адаптировать LLM общего назначения к разнообразным сценариям задач, таким как моделирование перспективы определенных демографических групп через контекстную ролевую игру [22]. Недавние исследования показывают, что эффективный агентный рабочий процесс может значительно улучшить способности LLM к моделированию человеческого поведения [105, 127], взаимодействию человека с LLM [89] и совместному решению задач [107]. Способность программировать LLM с агентным рабочим процессом закладывает основу для улучшения способностей LLM к рассуждению с помощью сложной когнитивной архитектуры.

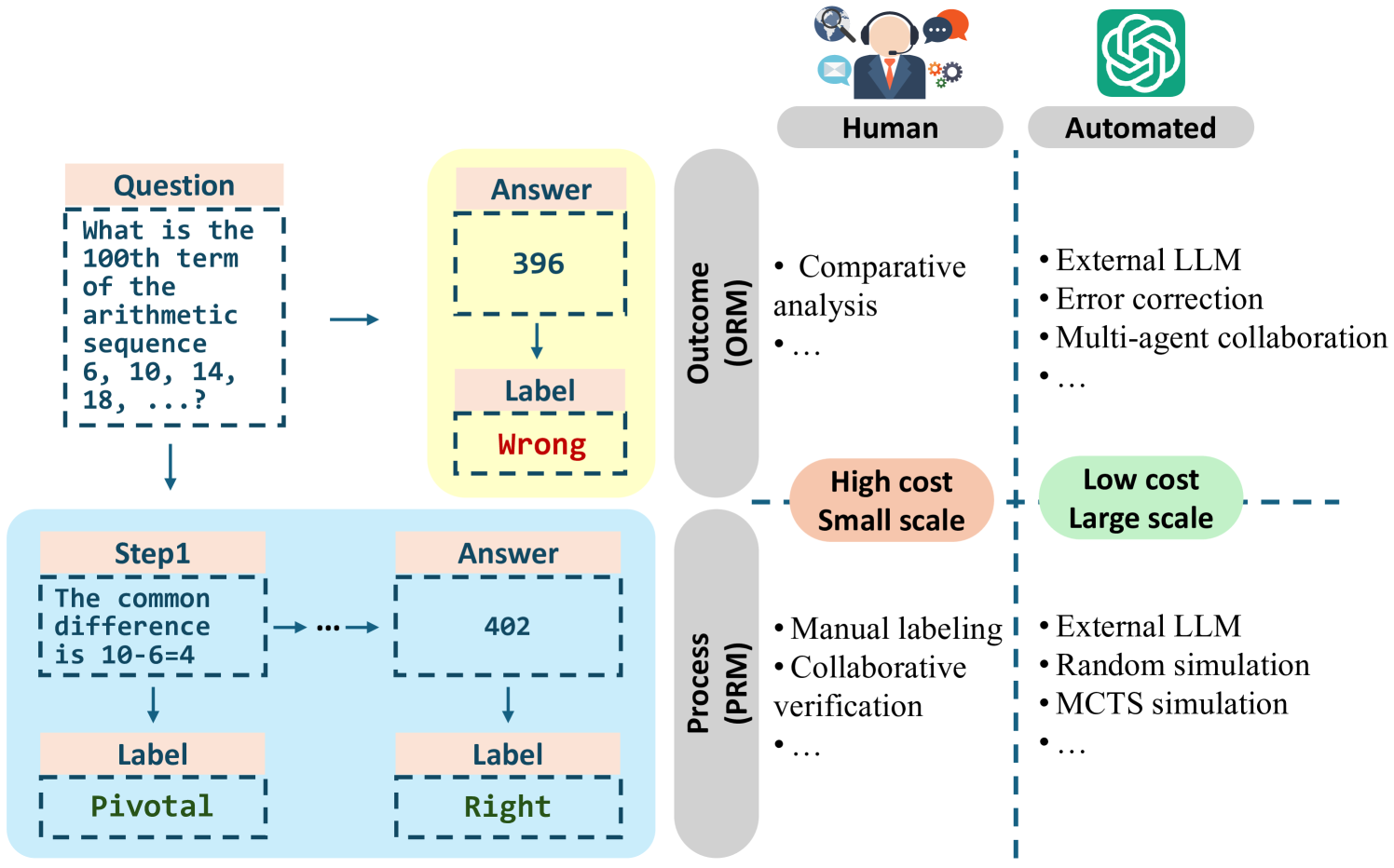

Рис.2. Иллюстрация различных парадигм для аннотирования данных рассуждений LLM.

3 Подготовка данных. От ручной разметки к использованию LLM (Data Construction: from Human Annotation to LLM Automation)

Создание крупномасштабных, высококачественных наборов данных для рассуждений имеет решающее значение для улучшения способностей больших языковых моделей (LLM) к рассуждению. Однако эта задача представляет значительные трудности из-за высокой стоимости. Как показано на рисунке 1, аннотирование человеком широко считается высококачественным, но оно чрезвычайно дорогое и сложное для масштабирования. В свою очередь, автоматизация процесса аннотирования с помощью LLM предлагает более экономически эффективную альтернативу, но сталкивается с проблемой ограниченной валидации, особенно для пошаговых процессов рассуждения. В этом разделе мы рассматриваем последние исследовательские усилия в этой области (обобщено в таблице 1), подчеркивая переход от аннотирования человеком к автоматизации с помощью LLM.

| Method | Label | Paper | Year | Task | Brief Description |

|---|---|---|---|---|---|

| Human Annotation | Outcome | [98] | 2024 | Text classification, Semantic analysis | Voting annotation |

| Human Annotation | Process | [104] | 2022 | Preference Alignment | Preference ranking |

| Human Annotation | Process | [75] | 2023 | Mathematical reasoning | Stepwise annotation |

| Human-LLM Collaboration | Outcome | [42] | 2023 | Semantic analysis | Human correction |

| Human-LLM Collaboration | Outcome | [152] | 2024 | Text classification | Human correction |

| Human-LLM Collaboration | Outcome | [74] | 2023 | Text classification, Semantic analysis | Task allocation, Uncertainty assessment |

| LLM Automation | Outcome | [106] | 2020 | Commonsense reasoning | Text extraction |

| LLM Automation | Outcome | [120] | 2024 | Tool use | Trial and error |

| LLM Automation | Outcome | [65] | 2024 | Embodied tasks | Synthetic augmentation |

| LLM Automation | Outcome | [109] | 2024 | Commonsense reasoning, Domain knowledge reasoning | Multi-agent collaboration |

| LLM Automation | Process | [84] | 2023 | Mathematical reasoning | Stronger LLM |

| LLM Automation | Process | [148] | 2024 | Mathematical reasoning | Monte Carlo simulation |

| LLM Automation | Process | [156] | 2024 | Mathematical reasoning, Programming | Monte Carlo simulation |

| LLM Automation | Process | [85] | 2024 | Mathematical reasoning | MCTS simulation |

| LLM Automation with feedback | Outcome | [70] | 2024 | Text classification, Mathematical reasoning, Domain knowledge reasoning | Self-refining |

| LLM Automation with feedback | Outcome | [135] | 2024 | Embodied tasks | Contrastive learning |

| LLM Automation with feedback | Process | [183] | 2024 | Mathematical reasoning, Domain knowledge reasoning | MCTS simulation, Self-refining |

Таблица 1: Построение обучающих данных для рассуждающих LLM.

3.1 Аннотирование человеком

Роль аннотирования человеком в создании наборов данных для больших языковых моделей (LLM) является неоценимой. Аннотаторы-люди характеризуются своей тщательностью, терпением и точностью, а также своей адаптивностью к новым сценариям и способностью эффективно обрабатывать неоднозначные данные [98]. Чжоу и др. [195] демонстрируют, что даже с минимальным количеством аннотированных человеком данных модели могут достигать высокой производительности, подчеркивая критическую роль тщательно подобранных аннотаций в эффективности модели. Данные, аннотированные человеком, играют ключевую роль в улучшении способностей к рассуждению больших языковых моделей. В контексте обучения с подкреплением на основе обратной связи от человека (RLHF) [104], данные предпочтений от аннотаторов-людей позволяют LLM, изначально обученным на общих текстовых корпусах, соответствовать сложным человеческим ценностям и этическим соображениям. Этот обобщаемый подход к аннотированию помогает в тонкой настройке моделей для конкретных задач. Основываясь на этом фундаменте, Лайтман и др. [75] продемонстрировали эффективность использования аннотаторов-людей для оценки качества рассуждения на каждом этапе процессов математического рассуждения, значительно улучшая точность рассуждений LLM. Это подчеркивает, как аннотирование человеком может преодолеть разрыв между общими обучающими данными и специфическими для домена задачами, такими как сложные задачи рассуждения.

Улучшение способностей к рассуждению в LLM требует супервизии процесса, где аннотаторы-люди руководят каждым шагом процесса рассуждения [75]. Однако такая супервизия требует обширных данных, аннотированных человеком, что делает ее ресурсоемкой и неустойчивой. Учитывая, что обучение LLM обычно требует терабайтов данных, объем которых критичен для производительности модели, создание наборов данных исключительно через ручное аннотирование становится все более непрактичным. Это подчеркивает необходимость альтернативных подходов для улучшения рассуждения без исключительной зависимости от аннотирования человеком. Одним из перспективных подходов является сотрудничество между людьми и LLM для аннотирования, где LLM используются для ускорения процесса при сохранении высокого качества аннотаций, созданных человеком. Конкретно, процесс аннотирования можно разделить на два этапа: этап предварительного аннотирования и этап уточнения. На этапе предварительного аннотирования LLM могут быть использованы для выполнения начального раунда аннотаций, используя несколько предоставленных вручную примеров для быстрой и эффективной настройки [42, 61]. На этапе уточнения аннотаторы-люди могут оценивать качество аннотаций, созданных LLM, и сосредоточиться на исправлении только той части аннотаций, которая имеет низкое качество [61, 152, 96, 42]. Для обеспечения масштабируемых процессов аннотирования последние работы все больше сосредоточены на том, как максимизировать автоматизацию, обеспечивая при этом качество данных, тем самым уменьшая вовлеченность человека без ущерба для точности аннотаций.

3.2 Автоматизированное аннотирование исходов с помощью LLM

Аннотирование данных — это сложная и ресурсоемкая задача, особенно в сценариях, требующих сложных операций, таких как фильтрация, идентификация, организация и реконструкция текстовых данных. Эти задачи часто бывают утомительными, трудоемкими и требуют значительных усилий человека, что делает их дорогостоящим узким местом в крупномасштабных усилиях по созданию данных [142, 31]. Для решения этих проблем использование LLM для аннотирования данных предоставляет экономически эффективную и эффективную альтернативу. С длиной контекстного окна, превышающей 100 000 токенов, LLM могут легко обрабатывать длинные тексты и большие объемы структурированных данных [2], справляясь с сложными требованиями аннотирования данных с замечательной эффективностью. Их сильные способности следовать инструкциям [187] позволяют им гибко адаптироваться к разнообразным и сложным сценариям аннотирования, достигая уровня качества, сравнимого с аннотаторами-людьми. Автоматизируя эти сложные задачи, LLM значительно сокращают зависимость от человеческого труда, оптимизируя процесс аннотирования и повышая общую производительность [181].

LLM способны выполнять широкий спектр задач автоматизированного аннотирования, начиная от простого извлечения вопросов и ответов [106] и заканчивая включением дополнительной целевой информации [161]. Без демонстраций человека LLM полагаются на свои мощные способности к рассуждению и контекстному обучению, чтобы самостоятельно решать более сложные задачи аннотирования. Например, Шик и др. [120] продемонстрировали, как LLM могут быть использованы для создания наборов данных для использования инструментов. Для каждого кандидата на позицию, которая может потребовать вызова API, LLM способны понимать логические связи в окружающем контексте, генерировать соответствующие вопросы и идентифицировать подходящий инструмент API для решения проблемы. Когда демонстрации человека доступны, LLM могут дополнительно улучшить свою производительность, имитируя паттерны и стратегии рассуждения, представленные в этих примерах. Для сложных задач демонстрации человека предоставляют высококачественные траектории — последовательности мыслей, наблюдений или действий, которые руководят LLM в воспроизведении процессов принятия решений человеком.

Существующие исследования показали, что даже LLM с нулевым обучением, руководствуясь агностическими к задаче подсказками на основе демонстраций человека, могут эффективно выполнять задачи аннотирования [65]. Более того, для задач, включающих высоко сложные и нюансированные траектории, LLM могут включать специализированные агенты, такие как Plan-Agent, Tool-Agent и Reflect-Agent, для решения различных аспектов процесса аннотирования, тем самым дополнительно улучшая их способность соответствовать человекообразному рассуждению и поведению [109]. Эти разнообразные способности естественным образом распространяются на задачи аннотирования исходов рассуждения, где LLM не только выводят основные логические структуры, но и систематически документируют промежуточные шаги рассуждения и связанные с ними выводы. Это позволяет создавать аннотированные наборы данных, которые захватывают не только конечные результаты, но и полные процессы рассуждения, ведущие к ним, предлагая более глубокие идеи для последующих приложений.

Помимо аннотирования с демонстрациями человека, LLM могут независимо улучшать свои способности к аннотированию через поиск с обратной связью, процесс, который включает итерационное улучшение за счет обучения в динамической среде. Неудачные данные могут рассматриваться как классическая форма обратной связи, служа ценной обратной связью для модели, чтобы идентифицировать слабые места и разрабатывать целевые корректировки. Путем самокоррекции ошибочных образцов и генерации уточненных обучающих данных LLM участвуют в цикле самосовершенствования, который укрепляет как их понимание, так и рассуждение [70]. Кроме того, LLM могут систематически анализировать причины своих ошибок, извлекая ключевые идеи и кодируя их как самообученные знания для руководства будущими задачами рассуждения [72]. Этот подход, основанный на обратной связи, также может включать сопоставление неудачных траекторий с успешными на основе сходства, позволяя использовать стратегии контрастного обучения для уточнения параметров модели. Через такие итерационные механизмы поиска и уточнения LLM не только исправляют ошибки, но и развивают более устойчивую способность к рассуждению, обеспечивая более глубокую обобщаемость и адаптируемость в сложных задачах [135].

3.3 Автоматизированное аннотирование процессов с помощью LLM

В сложных задачах рассуждения каждый шаг вывода модели может значительно влиять на конечный результат, что делает необходимым маркировать промежуточные решения как "правильные", "неправильные" или присваивать промежуточное вознаграждение, а именно аннотирование процесса. Однако ручная маркировка этих шагов является дорогостоящей и трудоемкой. Например, Лайтман и др. [75] вкладывают значительные усилия вручную для создания крупномасштабного набора данных с аннотациями процессов, то есть PRM800K, который удовлетворяет требованиям в обучении эффективной модели вознаграждения процессов (PRM) и значительно улучшает способность LLM к рассуждению. Поэтому все более необходимы автоматизированные методы для эффективного аннотирования процессов, обеспечивая масштабируемость и экономическую эффективность. Первоначальные автоматизированные подходы используют внешние более мощные LLM для аннотирования промежуточного процесса, сгенерированного меньшими LLM. Кроме того, метод на основе Монте-Карло уменьшает зависимость от внешних более мощных LLM и может использовать более слабые LLM для завершения аннотирования данных и, таким образом, обучать более мощные LLM посредством самоусиления.

Аннотирование с помощью более мощного LLM: В качестве прямого автоматизированного метода маркировки Луо и др. [84] предлагают использовать более мощную внешнюю модель для аннотирования промежуточных результатов процесса вывода генеративной модели. Вместо того чтобы полагаться на ручное аннотирование, этот метод использует предварительно обученную высокопроизводительную модель, такую как серия GPT, для оценки каждого сгенерированного шага. Используя возможности более мощной внешней модели, этот подход улучшает как точность, так и масштабируемость процесса маркировки, делая его более осуществимым для крупномасштабных задач. Однако основным ограничением этого подхода является его зависимость от высокоспособной внешней модели, что означает, что производительность процесса маркировки в конечном итоге ограничена возможностями используемой внешней модели.

Аннотирование с помощью симуляции Монте-Карло: Чтобы уменьшить зависимость от мощных внешних моделей, Ван и др. [148] и Ван и др. [156] предлагают улучшенный метод, который избегает прямого оценивания промежуточных шагов. Вместо этого их подходы используют внешнюю модель для продолжения рассуждения на несколько шагов от данного промежуточного вывода и случайно повторяют этот процесс симуляции несколько раз. Качество промежуточного шага затем оценивается на основе среднего результата этих расширенных выводов. Этот метод Монте-Карло показал многообещающие результаты в таких задачах, как решение математических проблем и генерация кода.

Аннотирование с помощью симуляции поиска по дереву: Подход использования многократной симуляции Монте-Карло с внешней моделью для оценки качества промежуточных шагов на основе средних результатов стал одним из наиболее широко используемых методов для автоматизированного аннотирования процессов. Чтобы еще больше повысить эффективность этого метода, Луо и др. [85] предлагают улучшение, заменяя повторяющиеся симуляции Монте-Карло на стратегию поиска по дереву Монте-Карло (Monte-Carlo Tree Search - MCTS). В этом улучшенном методе несколько листьев узлов, представляющих окончательные результаты вывода, генерируются из промежуточного шага с использованием MCTS. Качество промежуточного шага затем оценивается на основе средних результатов этих листьев узлов. По сравнению с случайными повторяющимися выводами, MCTS использует поиск по дереву для улучшения качества вывода, а также позволяет листьям узлов делиться высококачественными родительскими узлами, уменьшая вычислительные затраты и повышая эффективность. Этот метод продемонстрировал превосходную производительность в решении математических задач, превосходя аннотации человека.

Шаг вперед от симуляции на основе MCTS, Чжан и др. [183] вводят механизм самосовершенствования в аннотирование процессов. Они используют полученные аннотации процессов для обучения функции вознаграждения процесса (PRM), которая, в свою очередь, улучшает производительность большой языковой модели (LLM). Уточненная LLM затем используется для повторения симуляции на основе MCTS, генерируя аннотации более высокого качества. Этот итерационный процесс, включающий повторяющиеся циклы улучшения, приводит к прогрессивно улучшенным аннотациям процессов. Этот метод показал отличную производительность в нескольких задачах, включая решение математических задач, вопросы и ответы, и рассуждения в нескольких доменах, демонстрируя его эффективность в непрерывном уточнении и улучшении качества аннотаций через итерационное улучшение.

4. Обучение рассуждению: от SFT до Reinforcement Fine-tuning

Хотя предобученные модели демонстрируют отличные результаты в различных задачах, они часто сталкиваются с трудностями в сложных рассуждениях и согласовании выходных данных с человеческими ожиданиями. Тонкая настройка имеет решающее значение для преодоления этих ограничений, улучшая производительность модели в конкретных задачах и усиливая её способности к рассуждению. Изначально используется контролируемая тонкая настройка (SFT), где модели обучаются специфическим для задачи паттернам на основе размеченных наборов данных. Однако по мере усложнения задач рассуждения такие методы, как обучение с подкреплением (RL) и прямая оптимизация предпочтений (DPO), предлагают более эффективный подход, используя модели вознаграждения для более эффективного согласования выходных данных модели с человекообразным рассуждением, способствуя созданию более связных, ответственных и контекстуально осведомленных результатов.

4.1 Оптимизация предобученных LLM: контролируемая тонкая настройка

Контролируемая тонкая настройка — это техника обучения, которая уточняет возможности предобученных моделей для конкретных задач или доменов с использованием размеченных данных, сохраняя при этом понимание модели предобученных знаний. В то время как предобучение позволяет моделям изучать широкие, универсальные особенности из огромных объемов неструктурированных данных, тонкая настройка специализирует модель, знакомя её с меньшими, специфичными для задачи наборами данных с четкими соответствиями входных и выходных данных.

SFT является критическим шагом в улучшении способности LLM к рассуждению, позволяя их применение в последующих задачах, адаптируя их от универсальных систем к инструментам, специфичным для домена. Например, LLM, такие как GPT [111], BERT [30] и T5 [113], предобучаются на огромных объемах текстовых данных с использованием самообучения, что наделяет их широкими возможностями понимания и генерации языка. Однако их выходные данные не всегда соответствуют специфическим требованиям задачи. Без тонкой настройки LLM, как правило, плохо справляются с определенными задачами рассуждения, такими как подсчет объектов [182], понимание спутниковых данных [91] и ответы на инженерные вопросы [154]. С помощью SFT мы можем частично решить эти проблемы, уточняя выходные данные модели на основе размеченных, специфичных для задачи наборов данных.

Однако прямое применение SFT может не полностью раскрыть способности модели к рассуждению в желаемых доменах, особенно в задачах, требующих более сложного принятия решений или многоэтапного решения проблем. Введение техник цепочки мыслей (CoT) [160] революционизировало процесс SFT, обучая модель явно генерировать промежуточные шаги рассуждения перед получением ответа. С помощью SFT на основе CoT LLM поощряются к явной генерации промежуточных шагов рассуждения, что усиливает их способность решать задачи, требующие более структурированных и организованных мыслей. Например, ReasonBert [29] показывает, что тонкая настройка моделей с цепочками рассуждений значительно улучшает их производительность в таких задачах, как математические текстовые задачи и логическое рассуждение, за счет включения пошаговых процессов рассуждения. Другое ключевое исследование [80] изучает, как тонкая настройка моделей с рассуждением улучшает их интерпретируемость и уменьшает ошибки в сложных сценариях принятия решений за счет генерации более прозрачных, пошаговых процессов мышления. С помощью тонкой настройки с CoT модели не только улучшают свои окончательные ответы, но и усиливают способность "продумывать" проблему, предоставляя более четкие идеи о процессе рассуждения модели.

Несмотря на разнообразие методов и выдающуюся производительность SFT, она имеет несколько ограничений. Во-первых, SFT сильно зависит от высококачественных размеченных наборов данных, которые могут быть дорогими и трудоемкими для создания, особенно для нишевых доменов или задач, требующих экспертных аннотаций. Во-вторых, SFT может привести к катастрофическому забыванию, когда модель теряет часть своих предобученных универсальных знаний в процессе тонкой настройки, снижая её полезность для задач рассуждения вне домена тонкой настройки. Наконец, вычислительные затраты на тонкую настройку крупномасштабных моделей могут быть запретительными, даже с параметрически эффективными подходами, что создает проблемы для организаций с ограниченными ресурсами. Преодоление этих ограничений требует тщательной курации наборов данных, применения методов регуляризации и исследования альтернативных методов, таких как настройка подсказок или многозадачная тонкая настройка, для баланса между специализацией задачи и обобщением.

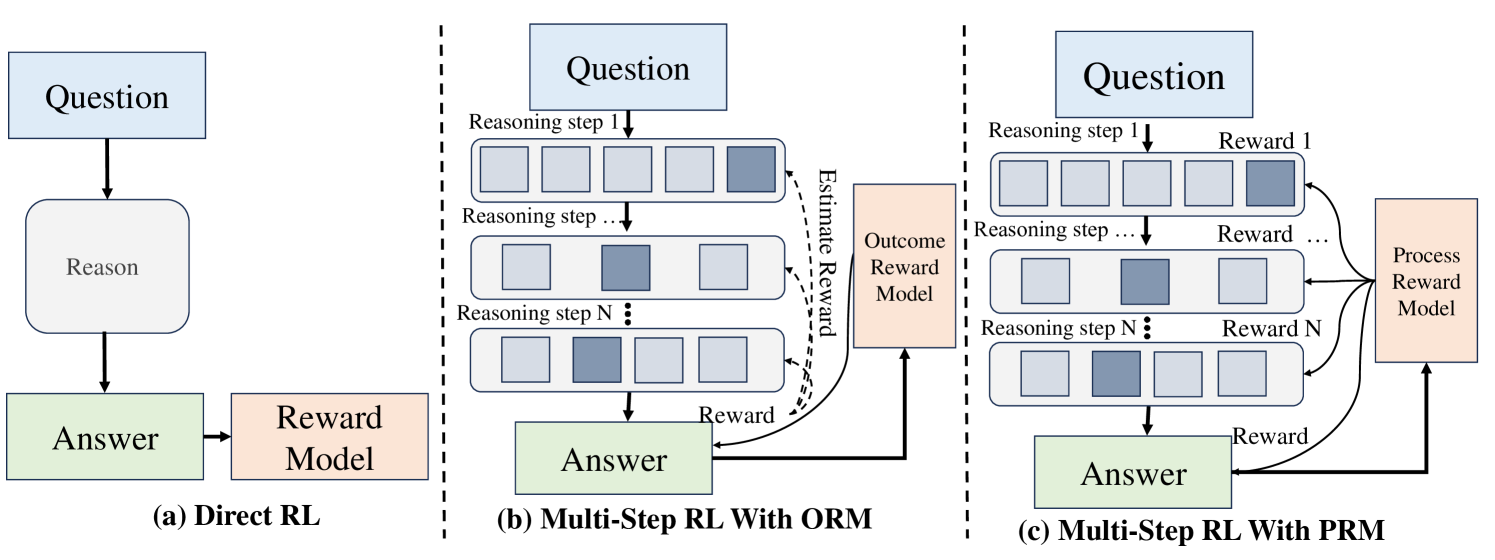

Рис.3. Reward models for Train-time Reinforcement of LLM Reasoning

4.2. Оптимизация предобученных LLM: обучение с подкреплением

Из-за высокой зависимости от дорогих высококачественных размеченных наборов данных и высоких вычислительных затрат на контролируемую тонкую настройку (SFT), обучение с подкреплением (RL) стало мощной альтернативной основой для обучения моделей овладению процессами рассуждения. В отличие от обучения с учителем, RL позволяет моделям учиться методом проб и ошибок с использованием сигналов вознаграждения, обнаруживая оптимальные стратегии для достижения конкретных целей. Как показано на рисунке 3 (a), модель принимает действие на основе своего текущего состояния и получает обратную связь в виде сигнала вознаграждения. Эта обратная связь направляет модель на обновление своих параметров с течением времени, оптимизируя кумулятивные вознаграждения.

Классическое обучение с подкреплением

Обучение с подкреплением стало критическим шагом в развитии LLM. В рамках RL параметры LLM обновляются на основе вознаграждений за их действия. Конкретно, функция ценности или Q-функция обновляется на основе обратной связи модели вознаграждения, приписывая заслугу за результат действия полностью его непосредственному эффекту. Этот подход упрощает структуру, делая её концептуально простой, одновременно улучшая способность модели эффективно реагировать. Два ключевых метода в настоящее время доминируют в обучении RL для LLM: обучение с подкреплением на основе обратной связи от человека (RLHF) и обучение с подкреплением на основе обратной связи от ИИ (RLAIF).

Оуян и др. [104] используют RLHF для согласования LLM с человеческими намерениями. Кроме того, путём тонкой настройки GPT-3 на демонстрациях и ранжировании, размеченных человеком, они разрабатывают модель вознаграждения, предсказывающую предпочтения аннотаторов-людей. Это эффективно согласовывает обученные LLM с человеческими предпочтениями, превосходя GPT-3 в рассуждении и следовании инструкциям, несмотря на меньший размер. Бай и др. [8] также используют RLHF для создания полезных и безопасных языковых моделей. Следуя принципам полезности, честности и безвредности, они тонко настраивают базовую модель, обучают модель предпочтений с использованием выборки отказов и итеративно уточняют её с помощью обратной связи от человека. Этот процесс создаёт ИИ-ассистентов, которые преуспевают в задачах обработки естественного языка и демонстрируют сильное этическое рассуждение.

Чтобы уменьшить зависимость от больших наборов данных, размеченных человеком, Бай и др. [9] предлагают Конституционный ИИ, основу для обучения ИИ-ассистентов быть полезными и безвредными с использованием принципов вместо дорогой обратной связи от человека. Процесс включает два этапа: обучение с учителем и RLAIF. На этапе обучения с учителем модель критикует и уточняет свои выходные данные на основе конституционных принципов, создавая набор данных для тонкой настройки. На этапе RLAIF модель генерирует самооценки для руководства обучением, обходя необходимость в данных, размеченных человеком, о вредности. Рамамурти и др. [114] сосредоточены на использовании RL для согласования LLM с человеческими предпочтениями. Они представляют RL4LMs, библиотеку для тонкой настройки на основе RL, и бенчмарк GRUE, который оценивает модели с использованием функций вознаграждения, отражающих человеческие предпочтения. Для решения проблем обучения они предлагают алгоритм оптимизации политики на естественном языке, который стабилизирует обучение, ограничивая выборку токенов. Эта работа предоставляет прочную основу для интеграции RL в тонкую настройку LLM для улучшения согласования и производительности.

Классическая оптимизация предпочтений

Классические методы RL полагаются на обучение модели вознаграждения для оценки выходных данных на основе человеческих предпочтений. В то время как DPO упрощает этот процесс, непосредственно используя данные предпочтений без необходимости в явной модели вознаграждения. Вместо оптимизации сложной функции вознаграждения, DPO использует парные сравнения предпочтений, то есть данные, указывающие, какой из двух выходных данных предпочитают люди. Этот прямой подход упрощает конвейер обучения, сохраняя преимущества согласования методов на основе RL, которые часто проще и эффективнее. Рафаилов и др. [112] представляют DPO, новую основу для согласования языковых моделей, которая непосредственно оптимизирует политику для согласования с человеческими предпочтениями через простую функцию потерь классификации. Параметризуя модель вознаграждения для вывода оптимальной политики в закрытой форме, DPO устраняет необходимость в выборке и обширной настройке гиперпараметров во время тонкой настройки. Эксперименты показывают, что DPO соответствует или превосходит методы RLHF, такие как PPO, в задачах, таких как контроль тональности, суммаризация и генерация диалогов, будучи более стабильным, вычислительно эффективным и эффективным в создании рассуждающих выходных данных. Амини и др. [4] предлагают оптимизацию прямых предпочтений со смещением (Direct Preference Optimization with an Offset - ODPO), расширение DPO для согласования языковых моделей с человеческими предпочтениями. ODPO улучшает DPO, учитывая степень предпочтения между ответами, а не рассматривая все пары предпочтений одинаково. Он вводит смещение в разнице правдоподобия между предпочтительными и непредпочтительными ответами, пропорциональное их разнице в качестве. Этот подход не только улучшает согласование, но и укрепляет способность модели к рассуждению, особенно в задачах, таких как контроль тональности, снижение токсичности и суммаризация. Эксперименты демонстрируют, что ODPO достигает лучшего согласования и ответственного поведения, особенно когда данные предпочтений ограничены.

В заключение, методы RL и DPO предлагают простой и эффективный способ развития способности к рассуждению у LLM. Фокусируясь на непосредственных вознаграждениях после каждого действия, эти методы также согласовывают модели с человеческими предпочтениями. Акцент на краткосрочной обратной связи упрощает процесс обучения, избегая сложностей распределения награды по длинным последовательностям. Этот упрощённый подход особенно хорошо подходит для приложений в реальном времени и задач, требующих чётких, кратких рассуждений, в конечном итоге укрепляя способность LLM предоставлять связные и этичные результаты.

4.3. Улучшение многоэтапного рассуждения с моделью вознаграждения за исход

Для сложных задач рассуждения, таких как решение математических задач, LLM необходимо выполнять многоэтапное рассуждение, подобное цепочке мыслей, чтобы в конечном итоге прийти к точному решению. В этих задачах обратная связь о вознаграждении обычно доступна только после завершения всех этапов рассуждения и получения окончательного решения. Как показано на рисунке 3 (b), это известно как модель вознаграждения за исход (Outcome Reward Model - ORM). В таких случаях ключом к улучшению способности LLM к рассуждению является различение правильности и важности промежуточных этапов рассуждения на основе вознаграждений за исходы.

Классическое обучение с подкреплением

ReFT [143] применяет метод PPO (Proximal Policy Optimization) [121] из RLHF [104] к задачам рассуждения. На основе модели вознаграждения за исход функция ценности в PPO способна выводить вклад промежуточных этапов рассуждения. По сравнению с контролируемой тонкой настройкой, ReFT способен изучать более разнообразные пути рассуждения, демонстрируя более сильные способности к обобщению в задачах рассуждения. Однако VinePPO [60] обнаруживает, что сеть ценностей, обученная с ORM в PPO, демонстрирует значительное смещение при идентификации ценности промежуточных этапов рассуждения, известная проблема в RL, называемая проблемой распределения заслуг. Чтобы решить эту проблему, VinePPO отказывается от сети ценностей в PPO и вместо этого использует метод выборки Монте-Карло для вычисления несмещённых оценок функции ценности. Экспериментальные результаты демонстрируют, что VinePPO последовательно превосходит типичный PPO в задачах математического рассуждения. Обучение критическим этапам плана (CPL) — это метод, предназначенный для улучшения обобщения LLM в задачах рассуждения путём поиска в высокоуровневых абстрактных планах [150]. CPL использует поиск по дереву Монте-Карло (MCTS) для исследования различных этапов планирования в многоэтапных задачах рассуждения и использует Step-APO для изучения критически важных этапов плана. Этот подход позволяет моделям изучать более разнообразные пути рассуждения, тем самым улучшая обобщение на различных задачах. Затем модель итеративно обучает политику и модели наград для дальнейшего улучшения производительности. На каждом этапе модель политики генерирует этапы плана и окончательные решения, в то время как модель награды оценивает качество промежуточных этапов. Обучающие данные, сгенерированные MCTS, используются для обновления как модели политики, так и модели награды.

DPO - Прямая оптимизация предпочтений

В задаче математического рассуждения прямое использование метода DPO (Direct Preference Optimization) [112] для оптимизации предпочтений даёт неоптимальные результаты из-за наличия длинных этапов рассуждения в данных предпочтений. Амини и др. [4] представили ODPO, который уточняет DPO, учитывая степень предпочтения между ответами вместо того, чтобы рассматривать все пары предпочтений как равные. ODPO достиг значительных улучшений по сравнению с DPO в задачах математического рассуждения.

В заключение, основная проблема обучения на основе вознаграждений за исход заключается в различении правильности и важности промежуточных этапов рассуждения. Текущие методы, основанные в основном на выборке Монте-Карло или поиске по дереву Монте-Карло, имеют преимущества в оценке значимости этих промежуточных этапов, хотя вычислительные затраты во время поиска остаются высокими. Существующие работы в основном сосредоточены на математических или других задачах рассуждения, где окончательные решения могут быть легко проверены. Эти методы могут быть расширены на более широкий спектр задач рассуждения, включая те, где решения трудно проверить. Потенциальный подход заключается в обучении модели вознаграждения на основе данных аннотаций человека и использовании её для оценки качества окончательного решения. На основе окончательного балла, предоставленного моделью вознаграждения, могут быть использованы методы выборки Монте-Карло или поиска для дальнейшего улучшения производительности.

4.4 Улучшение многоэтапного рассуждения с моделью вознаграждения за процесс

Обучение с подкреплением на основе модели вознаграждения за процесс (PRM) представляет собой значительное продвижение в рассуждении LLM, подчеркивая оценку промежуточных этапов, а не только фокусируясь на конечных результатах. Как показано на рисунке 3 (c), вознаграждение PRM распределяется по каждому этапу рассуждения, а не концентрируется на конечных результатах. Предоставляя нюансированную обратную связь на протяжении всей траектории рассуждения, PRM позволяет моделям оптимизировать поведение с большим соответствием человеческим предпочтениям и сложным требованиям задач. Этот подход важен для задач, включающих последовательное принятие решений, где промежуточные этапы или решения имеют значение для конечной цели. Мы исследуем эволюцию PRM и подчеркиваем их роль в улучшении рассуждения за счет предоставления вознаграждений на уровне этапов во время сложных задач.

Классическое обучение с подкреплением

Серия недавних работ применяет PRM для математического или логического рассуждения, поскольку основополагающая работа OpenAI [75] доказала важность вознаграждения за процесс. SELF-EXPLORE [55] использует PRM для улучшения математического рассуждения, выявляя и исправляя "первые ошибки", которые являются начальными неверными шагами в решении проблем. Вознаграждая шаги, которые исправляют такие ошибки, PRM позволяет самообучающуюся тонкую настройку без необходимости в обширных аннотациях человека. Эта модель достигает значительных улучшений в точности на математических бенчмарках, таких как GSM8K и MATH, используя детализированную обратную связь на уровне шагов. MATH-SHEPHERD [149] представляет собой структуру PRM, разработанную для пошаговой проверки и усиления в задачах математического рассуждения. Автоматизируя процесс супервизии с помощью методов, вдохновленных MCTS, MATH-SHEPHERD устраняет необходимость в аннотациях человека, обеспечивая при этом высокую точность в многоэтапном решении проблем. PRM используются для усиления логического прогресса и правильности, что приводит к улучшению производительности на бенчмарках, таких как GSM8K и MATH. DeepSeekMath интегрирует PRM через групповую относительную оптимизацию политики (GRPO) [128], алгоритм RL, который оптимизирует вознаграждения на уровне шагов. PRM используются для улучшения математического рассуждения и согласованности рассуждений в различных доменах. Фокусируясь на промежуточных этапах рассуждения, DeepSeekMath достигает передовых результатов на нескольких бенчмарках, демонстрируя мощь PRM в математических доменах. Масштабирование автоматизированных верификаторов процессов представляет собой вариант PRM, верификаторы преимущества процессов (PAV), для оценки прогресса на уровне шагов в решении проблем [123]. PAV используют супервизию на уровне шагов для улучшения эффективности и точности алгоритмов поиска и обучения с подкреплением. Фокусируясь на шагах, которые делают значимый прогресс в направлении правильного решения, PAV позволяют добиться существенных улучшений в эффективности выборки, вычислительной эффективности и точности рассуждения по сравнению с моделями вознаграждения за исход. Это демонстрирует важность детализированных вознаграждений за процесс в масштабировании способностей LLM к рассуждению.

Интерактивные модели вознаграждения за процесс

PRM также применяются к интерактивным задачам, таким как беседа и многоходовое отвечающее на вопросы. ArCHer использует иерархический подход RL с использованием PRM для обучения агентов для многоходовых задач с длинным горизонтом [198]. Он реализует двухслойную систему: функция ценности высокого уровня оценивает вознаграждения на уровне высказываний, в то время как PRM низкого уровня оптимизирует генерацию токен за токеном в каждом ходе. Эта иерархическая структура обеспечивает более эффективное распределение заслуг и позволяет для нюансированного обучения языковых моделей для обработки многоходовых взаимодействий и задач рассуждения. Использование PRM позволяет ArCHer эффективно масштабироваться, достигая значительных улучшений в эффективности выборки и производительности в задачах агентов. Многоходовое обучение с подкреплением на основе предпочтений обратной связи от человека [126] интегрирует PRM в многоходовое обучение с подкреплением для оптимизации долгосрочных целей с обратной связью от человека. Алгоритм многоходовой оптимизации предпочтений (MTPO) сравнивает целые многоходовые взаимодействия для генерации сигналов предпочтений, где PRM используются для назначения пошаговых вознаграждений. Это позволяет агентам LLM согласовывать поведение с долгосрочными целями, улучшая общую производительность в динамических многоходовых задачах, таких как беседы и стратегическое принятие решений.

DPO - Прямая оптимизация предпочтений

Несколько недавних исследований используют MCTS для оптимизации многоэтапных задач рассуждения через прямую оптимизацию предпочтений [165, 17, 183, 16]. Например, SVPO [17] использует MCTS для автоматической аннотации предпочтений на уровне шагов для многоэтапных задач рассуждения. С точки зрения обучения ранжированию, он обучает явную модель ценности для воспроизведения поведения неявной модели вознаграждения. Кроме того, SVPO интегрирует явную модель ценности с DPO, где модель ценности не только помогает модели политики находить более эффективные пути рассуждения, но и направляет обучение предпочтений. Однако эти работы в основном сосредоточены сначала на сборе данных предпочтений или обучении модели вознаграждения, а затем на выполнении оптимизации политики на основе статических данных и предобученной модели вознаграждения. Си и др. [165] продвинули эти подходы, интегрировав сбор данных и оптимизацию предпочтений политики в итеративный процесс. Этот метод можно рассматривать как онлайн-версию прямой оптимизации предпочтений, где обновлённая политика итеративно используется для сбора предпочтений через MCTS.

Эволюция многоэтапных методов RL для LLM отражает переход от разреженной обратной связи на основе исходов к детализированной супервизии, ориентированной на процесс. PRM теперь являются центральным элементом прогресса в способности LLM к рассуждению, предлагая нюансированные, пошаговые вознаграждения, которые приводят к существенным улучшениям в задачах рассуждения. Будущие исследования могут сосредоточиться на уточнении этих моделей и расширении их применимости в различных доменах задач.

4.5. Reinforcement Fine-tuning

Reinforcement Fine-tuning (RFT) [101] — это техника, недавно предложенная OpenAI для настройки экспертных LLM, адаптированных к конкретным вертикальным доменам. В настоящее время RFT остаётся частью исследовательской программы, и технические детали не были полностью раскрыты. Доступная информация предполагает, что RFT использует небольшое количество данных предпочтений, предоставленных пользователями, вместе с моделью оценщика для оценки выходных данных LLM. Эта техника позволяет итеративно оптимизировать способности LLM к многоэтапному рассуждению. В результате техника RFT может улучшить стратегию рассуждения LLM при решении подобных проблем в оптимизированных доменах.

Модель оценщика

RFT вводит концепцию модели оценщика для оценки выходных данных LLM. Учитывая, что обучение с подкреплением обычно требует модели вознаграждения для предоставления обратной связи, оценщик, вероятно, аналогичен модели вознаграждения, преобразуя текстовые входные данные (например, вопросы и ответы) в скалярные значения качества рассуждения. Это предполагает, что оценщик может действовать как модель вознаграждения, обученная на данных предпочтений, предоставленных пользователем, потенциально работая либо как модель вознаграждения за исход, либо как модель вознаграждения за процесс [76].

Эффективность данных

В живых сессиях OpenAI было упомянуто, что RFT может обеспечить обучение в новых доменах с использованием всего нескольких десятков данных предпочтений пользователей. Это предполагает, что RFT способствует исследованию разнообразных путей рассуждения для решения задач на основе ограниченных данных предпочтений. Такой подход демонстрирует замечательно высокую эффективность выборки, одновременно снижая риск переобучения [56].

Стабильность обучения

Стабильность обучения с подкреплением — это известная сложная проблема, которая представляет значительные вызовы для её более широкого применения. Вариации в случайных начальных условиях или изменения определённых гиперпараметров могут значительно повлиять на результаты обучения RL. В контексте проекта RFT, OpenAI объявила о планах сделать эту технологию доступной для общественности через API, позволяя пользователям тонко настраивать доменно-специфичные экспертные модели с использованием своих собственных данных. Это заявление потенциально указывает на то, что RFT достиг уровня стабильности, достаточного для надёжной тонкой настройки языковых моделей с использованием методов RL.

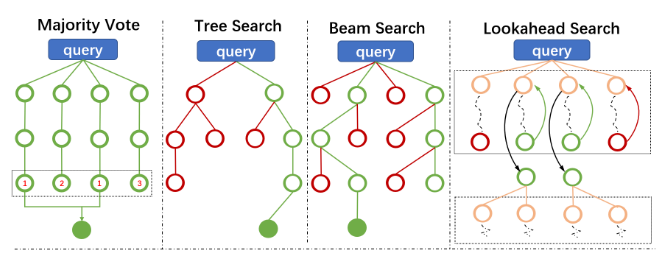

5. Масштабирование на этапе тестирования: от цепочек мыслей к поиску с руководством PRM

Рис.4. Diagrams of Different Search Algorithms for Test-time Reasoning Enhancement

5.1. Стимулирование осознанного мышления с помощью подсказок

Помимо оптимизации на этапе обучения с использованием таких методов, как обучение с подкреплением, исследователи обнаружили, что методы подсказок на этапе тестирования, такие как "Цепочка мыслей" и "Дерево мыслей", могут дополнительно улучшить возможности языковых моделей [160, 153]. В то время как простое требование от моделей прямых ответов часто дает неоптимальные результаты, руководство ими через явные процессы рассуждения на этапе тестирования значительно улучшает их производительность [62]. Эти стратегии подсказок показали замечательную эффективность в различных областях, от математических рассуждений до сложных задач принятия решений [173, 196]. Появление структурированных методов подсказок, таких как ReAct и "Подсказки от простого к сложному", продемонстрировало, что языковые модели могут извлечь выгоду из явного руководства в организации своих мыслительных процессов, что приводит к более надежным и интерпретируемым результатам [189]. Хотя эти подходы обычно увеличивают потребление токенов и вычислительные накладные расходы, они предоставляют убедительное дополнение к методам этапа обучения, улучшая способности языковых моделей к рассуждению и точность решений без необходимости изменения параметров модели [172, 11]. Это указывает на перспективное направление для улучшения производительности языковых моделей через сложные вмешательства на этапе тестирования, а не только за счет изменений в архитектуре модели или обучении.

5.2. Поиск с руководством PRM

Как упоминалось ранее, PRM знаменует значительный сдвиг от разреженной обратной связи на основе результатов к детальному процессуальному надзору. Более того, важно, что PRM также может использоваться на этапе тестирования, где он может дополнительно усилить способности модели к рассуждению. Модели серии OpenAI o1 являются ярким примером продвинутого применения PRM. Новые законы масштабирования на этапе тестирования предполагают, что способности к выводу могут быть эффективно улучшены за счет увеличения вычислительных мощностей на этапе тестирования, предоставляя четкое направление для будущего развития языковых моделей. Мы представляем некоторые методы, применяемые на этапе вывода, как показано на рисунке 3. Красные пустые кружки представляют пути рассуждений, отброшенные в процессе исследования алгоритма на этапе вывода, зеленые пустые кружки обозначают пути рассуждений, принятые в процессе исследования, а зеленые заполненные кружки отмечают конечные точки путей рассуждений после того, как правильный ответ идентифицирован.

Голосование большинством: Голосование большинством является одной из самых простых стратегий для генерации окончательного ответа из плотных вычислений на этапе тестирования. Во время вывода каждый след вывода производит предсказание для данного входа. Основная идея заключается в выборе ответа, с которым согласны большинство следов вывода. Предсказания от всех моделей затем агрегируются, и класс, который появляется наиболее часто (голосование большинством), выбирается в качестве окончательного вывода: \(f^* = \arg\max_f \sum_y \mathbb{I}_{\text{final\_ans}(y)=f}\), где \(\mathbb{I}\) — индикаторная функция, а \(y\) — каждый след оценки.

Поиск по дереву [15]: Поиск по дереву — это классический алгоритм, который систематически исследует различные варианты, рекурсивно строя дерево поиска. Он обычно используется в сложных задачах принятия решений, таких как настольные игры и задачи планирования. Поиск по дереву Монте-Карло (MCTS) является одним из наиболее широко используемых методов поиска по дереву. Он состоит из четырех основных шагов: выбор, расширение, симуляция и распространение. Постепенно расширяя пространство поиска, MCTS постепенно улучшает процесс принятия решений. Поиск по дереву уже применялся в некоторых задачах вывода языковых моделей, достигая заметного успеха. Например, фреймворк "Дерево мыслей" [172] позволяет языковым моделям рассматривать несколько путей рассуждений, структурированных как дерево. Он включает самооценку для принятия обдуманных решений, определяя оптимальный курс действий для следующего шага. Этот подход значительно улучшает производительность вывода модели.

Поиск по пучку [133]: Поиск по пучку — это улучшенная версия жадного поиска, обычно используемая в задачах генерации для выбора оптимальной выходной последовательности. Основная идея заключается в сохранении топ-K наивысших оцениваемых путей (называемых пучками) на каждом временном шаге из всех кандидатов для дальнейшего расширения. В отличие от жадного поиска, поиск по пучку поддерживает несколько кандидатов, тем самым расширяя пространство поиска и улучшая качество генерации. Поиск по пучку широко применяется в выводе языковых моделей. Например, BART [71] использует поиск по пучку в качестве своей основной стратегии вывода, демонстрируя его выдающуюся эффективность в задачах генерации текста.

Поиск с упреждением [134]: Поиск с упреждением — это еще один многообещающий метод, который имеет потенциал значительно улучшить вывод языковых моделей. Он модифицирует механизм оценки на каждом шаге поиска по пучку. Вместо выбора лучших кандидатов только на основе оценок текущего шага, поиск с упреждением выполняет прямые симуляции, разворачивая до k шагов вперед. Если конечная точка решения достигается во время прямой симуляции, процесс останавливается раньше. Во время поиска с упреждением используется предварительно обученная и замороженная модель предсказания вознаграждения для оценки каждого шага симуляции. Кумулятивные оценки, полученные от модели предсказания вознаграждения за k-шаговую симуляцию, затем используются для определения того, сохранять или отбрасывать ветвь пучка. Эта стратегия улучшает процесс принятия решений, включая больше контекста в каждый этап оценки. По сравнению с поиском по пучку, поиск с упреждением увеличивает глубину пространства исследования, позволяя судить о текущем принятии решений на основе результатов более далеких симулированных решений. Однако он также увеличивает потребность в вычислительных ресурсах, что также приводит к плохой производительности при ограниченных вычислительных ресурсах.

6. Путь к созданию крупных моделей рассуждения

6.1. Разработка серии OpenAI o1

В сентябре 2024 года OpenAI представила o1, революционную языковую модель, представляющую значительный прогресс в возможностях искусственного интеллекта в области рассуждений, особенно в сложных задачах, таких как математика, программирование и решение научных проблем. 20 декабря 2024 года OpenAI открыла тестирование заявок на o3, улучшенную версию o1 [102], которая считается обладающей интеллектом на уровне доктора наук [7]. Эти модели достигают выдающихся результатов по различным сложным бенчмаркам, включая получение золотого медального уровня на Международной математической олимпиаде [73] и соответствие уровню PhD в вопросах по физике, химии и биологии [48]. Обширные оценки показывают уникальные модели рассуждений серии o1 через систематический анализ её базовых возможностей рассуждения. Мы приводим ключевые выводы существующих исследований:

Эффективная интеграция знаний.

Первоначальные всесторонние оценки [194] демонстрируют структурированный аналитический подход o1 и интеграцию знаний в задачах фундаментального решения проблем, достигая 83,3% успеха в конкурентном программировании через пошаговое логическое выведение, где модель демонстрирует явную способность использовать свои знания для декомпозиции сложных проблем и следовать формальным процессам вывода. Структурированное понимание модели и взаимосвязанное применение знаний дополнительно подтверждается в специализированных областях, таких как радиология и проектирование микросхем, где точный диагноз и анализ сложных схем требуют интеграции множества концепций домена. Систематические оценки [68] количественно подтверждают эту модель, показывая 150% производительности на уровне человека в задачах структурированного аналитического мышления и вычислительного рассуждения. Это преимущество особенно заметно в сценариях, требующих интеграции знаний из разных областей, таких как применение физических принципов к биологическим системам или комбинирование статистических методов с ограничениями, специфичными для домена, что указывает на фундаментальную способность в синтезе и применении знаний.

Систематическая декомпозиция проблем.

o1 поддерживает стабильную производительность в задачах различного уровня сложности, демонстрируя систематическую декомпозицию проблем при увеличении сложности. В математических рассуждениях детальные исследования [27] показывают её систематический подход к декомпозиции проблем, достигая почти идеальных результатов на экзамене по математике B в Нидерландах через структурированные шаги решения. Модель демонстрирует способность идентифицировать ключевые математические принципы, строить формальные доказательства и проверять валидность решения шаг за шагом. Эта последовательность распространяется на более сложные сценарии, что подтверждается исследованиями [26] по 105 задачам по науке и математике возрастающей сложности, где модель сохраняет высокую точность даже при увеличении сложности проблем как в концептуальной глубине, так и в вычислительных требованиях. В задачах программирования эта модель дополнительно демонстрируется через систематическую отладку [52] на бенчмарке QuixBugs, где o1 поддерживает стабильную производительность в исправлении ошибок различной сложности через структурированный трёхэтапный подход: идентификация ошибок, анализ первопричин и целевая коррекция.

Надёжные и связные рассуждения в сложных задачах.

Рассуждения модели эффективно адаптируются к различным типам проблем, всегда демонстрируя последовательность цепочек рассуждений в различных задачах. В задачах планирования оценки PlanBench [144] демонстрируют её систематическое обращение как с детерминированными, так и с вероятностными сценариями, показывая значительное улучшение в удовлетворении ограничений и управлении состояниями. Модель демонстрирует особую силу в обработке проблем с неполной информацией и динамическими ограничениями, поддерживая стабильную производительность как в стандартных, так и в редких вариантах задач [94]. Эта адаптивность указывает на устойчивые возможности обобщения в различных формулировках проблем. Исследования по сложному планированию [146] дополнительно показывают способность o1 поддерживать связность рассуждений в задачах с длинным горизонтом, эффективно управляя расширенными цепочками зависимостей и переходами контекста. Это подтверждается её производительностью в многоэтапных задачах планирования, где промежуточные цели должны быть правильно последовательны, а зависимости тщательно управляемы, демонстрируя продвинутые возможности во временных рассуждениях и причинно-следственном понимании.

Новые законы масштабирования для крупных моделей рассуждения.

Эмпирические исследования демонстрируют уникальные модели масштабирования o1 как на этапах обучения, так и вывода. Во время обучения алгоритм обучения модели с подкреплением в большом масштабе учит её продуктивно мыслить, используя цепочку мыслей в высокоэффективном процессе [103]. Исследования [134] показывают, что благодаря оптимизированным стратегиям вычислительных ресурсов на этапе тестирования модель достигает значительных улучшений производительности в различных задачах рассуждения. Всесторонние оценки [194, 68] показывают, что возможности рассуждения o1 могут быть эффективно усилены за счёт продвинутого распределения вычислительных ресурсов на этапе вывода, особенно в сценариях сложного решения проблем. Ограничения на масштабирование этого подхода существенно отличаются от тех, что применяются при предобучении LLM, с постоянным улучшением производительности при увеличении времени, затрачиваемого на размышления [103]. Это подтверждается в задачах программирования, где разрешение 10,000 отправок на проблему позволяет модели достичь значительно лучших результатов, превышая порог золотой медали даже без стратегий выбора на этапе тестирования. Способность модели эффективно использовать дополнительные вычислительные ресурсы как на этапе обучения, так и на этапе вывода указывает на фундаментальное продвижение в архитектуре рассуждений, демонстрируя особую силу в сценариях, где традиционные подходы могут потребовать значительно больших размеров моделей.

6.2. Попытки открытого исходного кода в создании крупных моделей рассуждения

Фреймворки с открытым исходным кодом также сделали существенные шаги в развитии продвинутых возможностей рассуждения для языковых моделей. Эти фреймворки служат бесценными справочниками для исследователей и разработчиков, стремящихся воспроизвести или приблизить возможности рассуждения проприетарных моделей, таких как OpenAI o1. В этом разделе мы представляем четыре значимых усилия с открытым исходным кодом, каждое из которых использует различные стратегии для улучшения рассуждений языковых моделей (обобщено в Таблице 2). Исследуя их уникальные реализации, мы стремимся предоставить представление о разнообразных методологиях, используемых для усиления способностей к рассуждению в языковых моделях.

Таблица 2: Попытки открытого исходного кода в создании крупных моделей рассуждения: точка зрения вклада.

| Конструирование данных | Предобучение | Постобучение | Улучшение на этапе тестирования | |

|---|---|---|---|---|

| OpenR[145] | MCTS | - | GRPO | Best-of-N |

| Rest-MCTS*[183] | MCTS (в цикле) | - | SFT | Поиск по дереву |

| Journey Learning[110] | - | - | SFT | Поиск по дереву |

| LLaMA-Berry[185] | MCTS | - | DPO | Подсчёт Борда |

Проект OpenR[145].

Проект заявил, что это первый фреймворк с открытым исходным кодом, исследующий основные методы модели OpenAI o1 с использованием техник обучения с подкреплением. Основой репликации OpenR является конструирование данных пошаговых рассуждений, где получается более точная и детализированная обратная связь вместо чисто конечных ответов. Автоматизированный алгоритм увеличения данных OmegaPRM [85] используется путём выбора траекторий рассуждений из построенного дерева поиска. На основе увеличенных процессных данных с контролем на каждом шаге рассуждения, модель вознаграждения процесса дополнительно обучается в схеме контролируемого обучения, основанной на предобученной модели Qwen2.5-Math-7B-Instruct [168]. Модель вознаграждения процесса может быть непосредственно развёрнута на этапе вычислений при тестировании, интегрированная либо с голосованием большинства, либо с лучшими из N, либо с методами поиска по пучку. Она также может быть использована для тонкой настройки языковой модели на этапе постобучения с использованием обучения с подкреплением. Проводятся эксперименты для демонстрации эффективности модели вознаграждения процесса на этапе вычислений при тестировании и постобучении.

*Rest-MCTS[183].**

Вместо того чтобы обучать модель вознаграждения процесса и модель политики тонкой настройки отдельно, они интегрируют эти два обновления в один взаимный цикл самообучения. Вознаграждение процесса в качестве контроля для обучения модели вознаграждения процесса и траектории рассуждений для обучения модели политики собираются заранее на основе аналогично разработанного алгоритма MCTS. Затем начинается итеративный процесс обучения на основе начальной политики π и начальных значений модели вознаграждения процесса Vθ. Политика далее итеративно выполняет MCTS и генерирует решения, в то время как значения влияют на процесс поиска по дереву. Их обновления дополняют друг друга итеративно.

Проект Replication Journey o1[110].

Вместо того чтобы тщательно рассматривать улучшения реализации на обоих этапах, проект направлен на репликацию способностей рассуждения модели OpenAI o1, сосредотачиваясь на всеобъемлющих стратегиях обучения. Он делает акцент на структурированной схеме обучения, которая включает метод проб и ошибок, размышления и откат для построения глубоких причинных рассуждений. Основным аспектом проекта является генерация данных, с высококачественными обучающими примерами, предназначенными для моделирования сложных путей рассуждений. Используя метод обучения путешествием, Replication Journey o1 знакомит модель с различными логическими последовательностями и коррекциями, поощряя исследование и адаптивность на этапе обучения. Однако Replication Journey o1 менее изощрён на этапе вывода, не имея продвинутых техник постобучения, что ограничивает его адаптивность во время реального рассуждения. Этот акцент на обучении над выводом подчёркивает его фундаментальный подход по сравнению с моделями с динамическими оптимизациями вывода.

LLaMA-Berry[185].

Проект направляет своё внимание на оптимизацию способностей к рассуждению на этапе вывода, используя архитектуру LLaMA-3.1-8B для предоставления более сложных корректировок рассуждений в реальном времени. Он использует уникальный подход парной оптимизации, который сочетает поиск по дереву Монте-Карло с самоулучшением (SR-MCTS), позволяя модели динамически исследовать и улучшать пути решений на этапе вывода. Эта конфигурация предоставляет LLaMA-Berry высокий уровень адаптивности, позволяя эффективно и гибко решать сложные, открытые задачи рассуждения. Ключевым компонентом этого фреймворка является модель вознаграждения парных предпочтений (PPRM), которая оценивает пути решений парами, обеспечивая приоритет высококачественным путям рассуждений. Улучшенный подсчёт Борда (EBC) LLaMA-Berry затем консолидирует эти рейтинги предпочтений для руководства принятием решений моделью, дополнительно повышая её сложность на этапе вывода. Эта устойчивая архитектура позиционирует LLaMA-Berry как ведущий пример усиления вывода, отличая её от подхода O1 Replication Journey, ориентированного на обучение.

Эти четыре фреймворка с открытым исходным кодом не только демонстрируют различные стратегии реализации для усиленных рассуждений, но и играют важную роль в улучшении понимания модели OpenAI o1. Вместе они расширяют спектр техник, доступных сообществу открытого исходного кода, продвигая коллективную цель разработки сложных, прозрачных и адаптируемых моделей рассуждения, которые приносят возможности уровня проприетарных систем в общедоступные системы.

7 Другие методы улучшения на этапе тестирования

Помимо поиска, управляемого PRM, существует множество других методов, предназначенных для улучшения способностей LLM к рассуждению с использованием дополнительных вычислительных мощностей на этапе тестирования. Эти методы динамически уточняют результаты рассуждений без изменения самой модели. Подходы, такие как поиск с вербальным подкреплением, подкрепление на основе памяти и поиск в агентских системах, показанные на Рисунке 4, демонстрируют, что значительные улучшения в рассуждениях могут быть достигнуты с использованием готовых LLM. Выборка представительных работ, исследующих эти методы, суммирована в Таблице 3. Хотя эти методы не используют PRM, они предлагают основу для будущих исследований по изучению гибридных моделей для дальнейшего продвижения способностей к рассуждению.

Ссылка на подпись Рисунок 4: Типичные методы улучшения на этапе тестирования без обучения: поиск с вербальным подкреплением, подкрепление на основе памяти и поиск в агентских системах. Таблица 3: Список представительных работ по методам усиления на этапе тестирования без обучения.

| Метод | Категория | Представительная литература |

|---|---|---|

| Поиск с вербальным подкреплением | Индивидуальный агент | Romera et al.[115], Shojaee et al.[130], Mysocki et al.[162], Ma et al.[88] |

| Многоагентный | Chen et al.[20], Zhou et al.[199], Le et al.[69], Yu et al.[176] | |

| Воплощенный агент | Boiko et al.[13] | |

| Подкрепление на основе памяти | Опытное обучение | Zhang et al.[184], Gao et al.[39], Qian et al.[108] |

| Рефлексивное обучение | Shinn et al.[129], Sun et al.[138], Sun et al.[190] | |

| Обучение концептам | Zhang et al.[188], Gao et al.[40], Guan et al.[44] | |

| Поиск в агентских системах | Уровень подсказок | Madaan et al.[90], Fernando et al.[38], Yang et al.[169] |

| Уровень модулей | Shang et al.[125], Zhang et al.[186] | |

| Уровень агентов | Huot et al.[54], Zhuge et al.[200] |

7.1 Поиск с вербальным подкреплением

Поиск с вербальным подкреплением (VRS) использует предварительно обученные рассуждения и семантические способности LLM для исследования и оптимизации пространств решений. В отличие от традиционного обучения с подкреплением или методов, требующих интенсивного обучения, VRS работает исключительно через инференцию на этапе тестирования, используя итеративные циклы обратной связи для уточнения решений без необходимости дополнительного обучения. Опираясь на семантические знания, закодированные в LLM, и их способность следовать сложным инструкциям, VRS предоставляет универсальный подход для навигации по разнообразным пространствам проблем. Этот фреймворк, основанный на инференции, находит применение в индивидуальных агентах, многоагентных системах и воплощенных агентах, поддерживая широкий спектр задач, включая программную оптимизацию, совместное принятие решений и взаимодействия в реальных условиях. В этом разделе анализируется VRS через эти три ключевых аспекта, углубляясь в методологии и уникальные идеи, представленные в каждой категории.